Möchten Sie, dass Ihre Daten privat bleiben und Ihr Gerät nie verlassen? Für Cloud-LLM-Dienste fallen häufig laufende Abonnementgebühren an, die auf API-Aufrufen basieren. Selbst Benutzer in abgelegenen Gebieten oder solche mit unzuverlässiger Internetverbindung bevorzugen Cloud-Dienste nicht ausdrücklich. Was ist also die Lösung?

Glücklicherweise können lokale LLM-Tools diese Kosten eliminieren und Benutzern die Ausführung von Modellen auf ihrer Hardware ermöglichen. Die Tools verarbeiten Daten auch offline, sodass kein externer Server auf Ihre Informationen zugreifen kann. Sie erhalten außerdem mehr Kontrolle über die Schnittstelle speziell für Ihren Workflow.

In diesem Leitfaden haben wir dies zusammengestelltkostenlose lokale LLM-Toolsum alle Ihre Bedingungen zu erfüllen und gleichzeitig Ihre Datenschutz-, Kosten- und Leistungsanforderungen zu erfüllen.

Hier sind einige kostenlose lokale LLM-Tools, die handverlesen und persönlich getestet wurden.

- Jan

- LM Studio

- GPT4ALL

- Alles LLM

- Zu sein

1] Jan

Kennen Sie ChatGPT? Wenn ja, ist Jan eine Version, die offline funktioniert. Sie können es auf Ihrem persönlichen Gerät ohne Internetverbindung ausführen. Damit können Sie Textdaten privat in Ihrem lokalen Netzwerk generieren, analysieren und verarbeiten.

Es verfügt über erstklassige Modelle wie Mistral, Nvidia oder OpenAI, die Sie verwenden können, ohne Daten an einen anderen Server zu senden. Dieses Tool ist geeignet, wenn Sie Prioritäten setzenund wollen eine robuste Alternative zu cloudbasierten LLMs.

Merkmale

- Vorgefertigte Modelle:Es stellt installierte KI-Modelle bereit, die ohne zusätzliche Verfahren einsatzbereit sind.

- Anpassung:Ändern Sie die Farbe des Dashboards und machen Sie das Design einfarbig oder durchscheinend.

- Rechtschreibprüfung:Verwenden Sie diese Option, um Rechtschreibfehler zu korrigieren.

Vorteile

- Importieren Sie Ihre Modelle mithilfe der Hugging Face-Quelle.

- Es unterstützt Erweiterungen zur individuellen Anpassung.

- Kostenfrei

Nachteile

- Weniger Community-Support Jan hat keinen Community-Support und Benutzer finden möglicherweise weniger Tutorials und Ressourcen.

Schauen Sie sich das LLM hier an

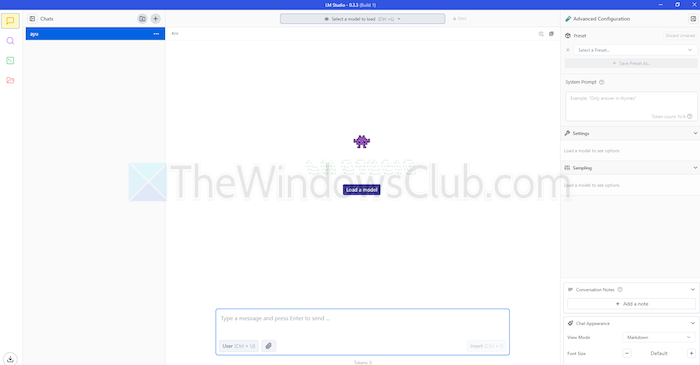

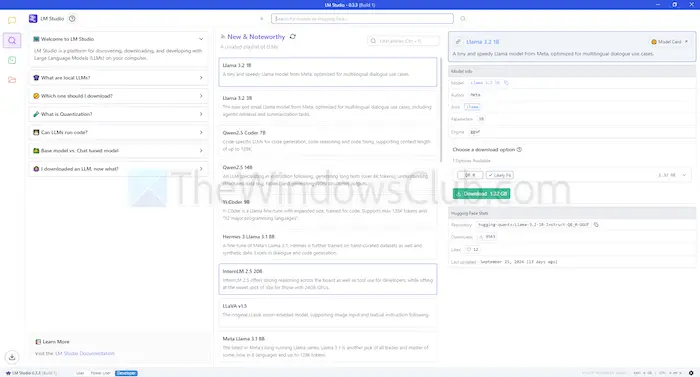

2] LM Studio

LM Studio ist ein weiteres Tool zur lokalen Verwendung von Sprachmodellen wie ChatGPT. Es bietet große, erweiterte Modelle, um Ihre Anfragen zu verstehen und darauf zu reagieren. Aber im Gegensatz zu cloudbasierten Modellen bleiben Sie auf Ihrem Gerät. Mit anderen Worten: Es gibt mehr Privatsphäre und Kontrolle über die Nutzung.

LM Studio kann Texte zusammenfassen, Inhalte generieren, Ihre gewünschten Fragen beantworten oder sogar beim Codieren unterstützen – alles von Ihrem Computer aus. Bevor Sie ein Modell ausführen, können Sie einen Bericht darüber erhalten, ob Ihr System damit umgehen kann. Dadurch können Sie Ihre Zeit und Ressourcen nur für kompatible Modelle verwenden.

Merkmale

- Dateianhänge und RAG:Sie können PDF-, DOCX-, TXT- und CSV-Dateien in die Chatbox hochladen und entsprechende Antworten erhalten.

- Umfang der Individualisierung:Es bietet mehrere Farbthemen und lässt Sie den Komplexitätsgrad der Benutzeroberfläche auswählen.

- Ressourcendichte:Es bietet kostenlose Dokumentation und Möglichkeiten zum Erlernen und Verwenden des Tools.

Vorteile

- Sie können es unter Linux, Mac oder Windows verwenden.

- Einrichtung eines lokalen Servers für Entwickler.

- Es bietet eine kuratierte Playlist mit Models

Nachteile

- Insbesondere für Neueinsteiger kann es schwierig sein, mit der Arbeit zu beginnen.

Schauen Sie sich das LLM hier an

3] GPT4ALL

GPT4ALL ist ein weiteres LLM-Tool, das Modelle auf Ihren Geräten ausführen kann, ohne dass eine Internetverbindung oder sogar eine API-Integration erforderlich ist. Dieses Programm läuft ohne GPUs, kann diese jedoch nutzen, sofern verfügbar, was es für viele Benutzer geeignet macht. Es unterstützt außerdem eine Reihe von LLM-Architekturen, wodurch es mit Open-Source-Modellen und Frameworks kompatibel ist.

Außerdem wird llama.cpp als Backend für LLMs verwendet, was die Modellleistung auf CPUs und GPUs ohne High-End-Infrastruktur verbessert. GPT4ALL ist sowohl mit Intel- als auch mit AMD-Prozessoren kompatibel; Es verwendet GPUs für eine schnellere Verarbeitung.

Merkmale

- Interaktion mit lokalen Dateien:Modelle können lokale Dateien abfragen und mit ihnen interagieren. Wie PDFs oder Textdokumente mit lokalen Dokumenten.

- Effizient:Viele Modelle sind in 4-Bit-Versionen erhältlich, die weniger Speicher und Rechenleistung verbrauchen.

- Umfangreiche Modellbibliothek:GPT4ALL verfügt über über 1000 Open-Source-Modelle aus Repositories wie Hugging Face.

Vorteile

- Open Source und transparent

- Es bietet ein spezielles Paket für Unternehmen zur lokalen Nutzung von KI.

- GPT4ALL legt großen Wert auf den Datenschutz

Nachteile

- Eingeschränkte Unterstützung für ARM-Prozessoren wie Chromebooks

Schauen Sie sich das LLM hier an

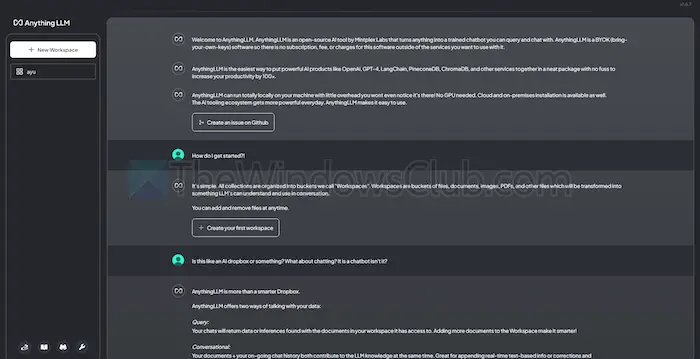

4] AnythingLLM

AnythingLLM ist ein Open-Source-LLM, das eine hohe Anpassungsfähigkeit und ein privates KI-Erlebnis bietet. Damit können Benutzer LLMs offline auf ihren lokalen Geräten wie Mac, Windows oder Linux bereitstellen und ausführen und so die Vollständigkeit gewährleisten

Darüber hinaus eignet sich das Tool am besten für Einzelanwender, die eine einfach zu installierende Lösung mit minimalem Setup wünschen. Sie können es als ein privates CharGPT-ähnliches System betrachten, das Unternehmen oder Einzelpersonen betreiben können.

Merkmale

- Entwicklerfreundlich:Es verfügt über eine vollständige API für die benutzerdefinierte Integration.

- Tool-Integration:Sie können zusätzliche Tools integrieren und API-Schlüssel generieren.

- Einfache Einrichtung:Es verfügt über einen Ein-Klick-Installationsprozess.

Vorteile

- Flexibilität bei der LLM-Nutzung

- Dokumentzentriert

- Die Plattform verfügt über KI-Agenten zur Automatisierung von Aufgaben

Nachteile

- Es fehlt die Unterstützung für mehrere Benutzer

- Komplexität in erweiterten Funktionen

Schauen Sie sich das LLM hier an

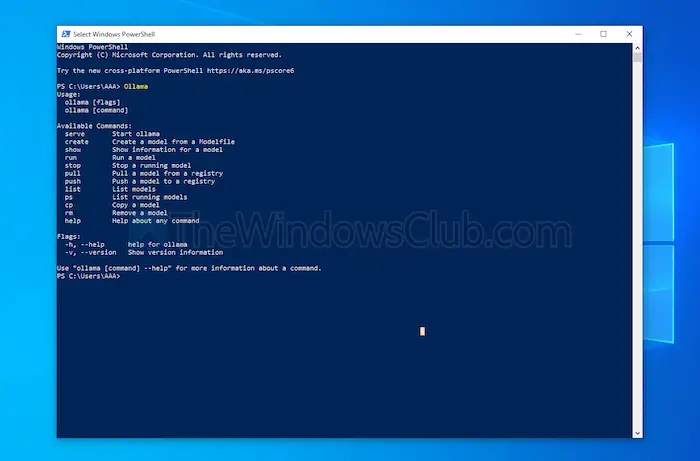

5] Sein

Ollama bietet die volle Kontrolle über die Erstellung lokaler Chatbots ohne API. Derzeit verfügt es über die bedeutendsten Mitwirkenden, die häufige Updates bereitstellen und die Gesamtfunktionalität von GitHub verbessern. Dadurch wird dieses Tool aktualisiert und bietet eine bessere Leistung als andere. Im Gegensatz zu den anderen oben besprochenen Tools öffnet es eine Terminalschnittstelle zum Installieren und Starten eines Modells.

Jedes von Ihnen installierte Modell verfügt über eigene Konfigurationen und Gewichtungen, wodurch Konflikte mit anderer Software auf Ihrem Computer vermieden werden. Neben seiner Befehlszeilenschnittstelle verfügt Ollama über eine mit OpenAI kompatible API. Sie können dieses Tool problemlos in eines integrieren, das OpenAI-Modelle verwendet.

Merkmale

- Lokale Bereitstellung:Mit Ollama können Sie große Sprachmodelle wie Llama, Mistral oder andere offline ausführen.

- Modellanpassung:Fortgeschrittene Benutzer können das Verhalten in Modellen mithilfe einer Modefile festlegen.

- OpenAI-API-Kompatibilität:Es verfügt über eine REST-API, die mit der API von OpenAI kompatibel ist.

- Ressourcenmanagement:Es optimiert die CPU- und GPU-Auslastung, ohne das System zu überlasten.

Vorteile

- Sie können eine Sammlung von Modellen erhalten.

- Es kann Modelle aus Open-Source-Bibliotheken wie PyTorch importieren.

- Ollama kann mit enormer Bibliotheksunterstützung integriert werden

Nachteile

- Es bietet keine grafische Benutzeroberfläche

- Erfordert große Speicheranforderungen

Schauen Sie sich das LLM hier an

Abschluss

Zusammenfassend lässt sich sagen, dass lokale LLM-Tools eine würdige Alternative zu cloudbasierten Modellen darstellen. Sie bieten kostenlos Privatsphäre und Kontrolle auf höchstem Niveau. Unabhängig davon, ob Sie eine einfache Bedienung oder eine individuelle Anpassung anstreben, bieten die aufgeführten Tools unterschiedliche Anforderungen und Fachkenntnisse.

Abhängig von Ihren Anforderungen, wie z. B. Rechenleistung und Kompatibilität, kann jede davon das Potenzial von KI nutzen, ohne die Privatsphäre zu beeinträchtigen oder Abonnementgebühren zu verlangen.

![[AskVG Apps] Kostenlose Software zum Optimieren und Anpassen von Windows herunterladen](https://media.askvg.com/articles/images8/OEM_Assigner_Add_OEM_Information_Logo_Windows_System_Settings.png)