Les grands modèles de langage ont révolutionné le traitement du langage naturel, mais leur utilisation nécessite souvent l'envoi de données à des serveurs externes. LocalGPT propose une solution en vous permettant d'exécuter ces modèles directement sur votre PC Windows, garantissant ainsi une confidentialité et un contrôle total sur vos données. Ce guide vous guidera tout au long du processus de configuration de LocalGPT, de l'installation à votre première interaction.

Qu’est-ce que LocalGPT ?

LocalGPT est un outil open source inspiré de privateGPT, conçu pour exécuter de grands modèles linguistiques (LLM) sur votre appareil local. Contrairement à son prédécesseur, LocalGPT prend en charge l'accélération GPU pour des performances améliorées et utilise le Vicuna-7B LLM et InstructorEmbeddings pour un traitement efficace. Cette configuration vous permet d'interagir avec des modèles d'IA sans connexion Internet, en conservant entièrement vos données sur votre système.

Conditions préalables

Avant de commencer, assurez-vous d'avoir :

- Un PC Windows avec au moins 8 Go de RAM (16 Go recommandés).

- Accès administrateur à votre ordinateur.

- Environ 10 Go d'espace disque libre.

- Un GPU NVIDIA (facultatif, mais recommandé pour de meilleures performances).

Configuration de LocalGPT sous Windows

Étape 1 :Installer Miniconda

Miniconda est une version allégée d'Anaconda que nous utiliserons pour gérer notre environnement Python :

1. Visitez le site Web Miniconda et téléchargez le dernier programme d'installation de Windows.

2. Exécutez le programme d'installation et suivez les invites. Lorsque vous atteignez « Options d'installation avancées », cochez toutes les cases.

3. Après l'installation, ouvrez le menu Démarrer et recherchez « Anaconda Prompt ». Ouvrez-le et tapezconda listpour vérifier l'installation.

Étape 2 :Télécharger LocalGPT

1. Accédez au référentiel LocalGPT GitHub.

2. Cliquez sur le bouton « Code » et sélectionnez « Télécharger ZIP ».

3. Extrayez le fichier ZIP vers un emplacement auquel vous pouvez facilement accéder, tel que votre bureau.

4. Renommez le dossier extrait en « LGPT » pour plus de simplicité.

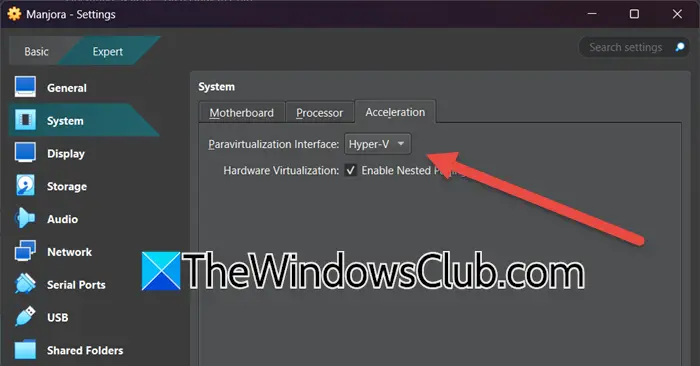

Étape 3 :Configurer l'environnement et installer les dépendances

1. Ouvrez l'invite Anaconda à partir du menu Démarrer.

2. Créez un nouvel environnement en exécutant :

conda create -n localgpt python=3.10

conda activate localgpt

3. Accédez à votre dossier LocalGPT :

cd Desktop

cd LGPT

4. Installez les packages requis :

pip install -r requirements.txt

Si vous rencontrez une « torch ModuleNotFoundError », exécutez :

pip install torch torchvision torchaudio

Si vous voyez une erreur « Microsoft C++ est requis », téléchargez et installez Visual Studio Build Tools à partir du lien fourni.

Étape 4 :Préparer et exécuter LocalGPT

1. Importez vos documents en exécutant :

python ingest.py

Ce processus peut prendre un certain temps en fonction de la quantité de données que vous importez.

Apprendre encore plus:Guide du débutant macOS : Comment utiliser un Mac pour les débutants

2. Ouvrez leconstants.pyfichier dans le répertoire LocalGPT. Commentez la ligne de modèle Llama 3 et décommentez la ligne de modèle Llama 2 (paramètres 7B).

3. Démarrez LocalGPT :

python run_local_gpt.py

Si vous obtenez une erreur concernant le « lama » manquant, exécutez :

pip install llama-cpp-python

Utiliser LocalGPT

Une fois LocalGPT exécuté, vous pouvez commencer à interagir avec lui via l'interface de ligne de commande. Posez des questions liées aux documents que vous avez ingérés et LocalGPT fournira des réponses basées sur sa base de connaissances locale.

N'oubliez pas que la qualité des réponses dépend des données que vous avez fournies et du modèle que vous utilisez. Expérimentez avec différentes requêtes pour avoir une idée de ses capacités.

Dépannage des problèmes courants

GPU non détecté :Si vous disposez d'un GPU NVIDIA mais que LocalGPT ne l'utilise pas, assurez-vous que les derniers pilotes CUDA sont installés et que votre GPU est compatible avec la version de PyTorch installée.

Erreurs de mémoire insuffisante :Si vous rencontrez des erreurs de mémoire insuffisante, essayez de réduire la taille du modèle dans leconstants.pyfichier ou en fermant d’autres applications gourmandes en ressources.

Performances lentes :Sur les systèmes sans GPU, le traitement peut être lent. Pensez à utiliser un modèle plus petit ou à réduire la quantité de données que vous ingérez.

La configuration de LocalGPT sur Windows ouvre un monde de possibilités pour les interactions IA privées et hors ligne. Au fur et à mesure que vous vous familiariserez avec le système, vous pourrez explorer des fonctionnalités avancées telles que l'échange de modèles ou le réglage précis de tâches spécifiques. N'oubliez pas de sécuriser vos modèles et données locaux, car ils contiennent toutes les informations que LocalGPT utilise pour générer des réponses.

![[NOUVEAU] Comment réparer PGSharp qui ne fonctionne pas](https://elsefix.com/statics/image/placeholder.png)

![Comment supprimer Mosyle MDM de l'iPad [3 façons]](https://elsefix.com/images/5/2024/09/1726475779_remove-mosyle-corporation-mdm.jpg)

![[Fix] Impossible d'installer Windows 8.1 ou Server 2012 R2 dans Oracle Virtual Box](https://media.askvg.com/articles/images5/Windows_8_1_VirtualBox_Install_Error.png)