Abra o seletor de modelo e escolha uma variante adequada à tarefa: escolhaGPT‑5 (thinking)para uma análise mais profunda ou volte paraGPT‑4oouo3quando GPT-5 parece conciso ou fora de tópico. Essa única alteração geralmente restaura a profundidade, a precisão e a estabilidade.

Método 1: Escolha o modelo certo (ou restaure os mais antigos)

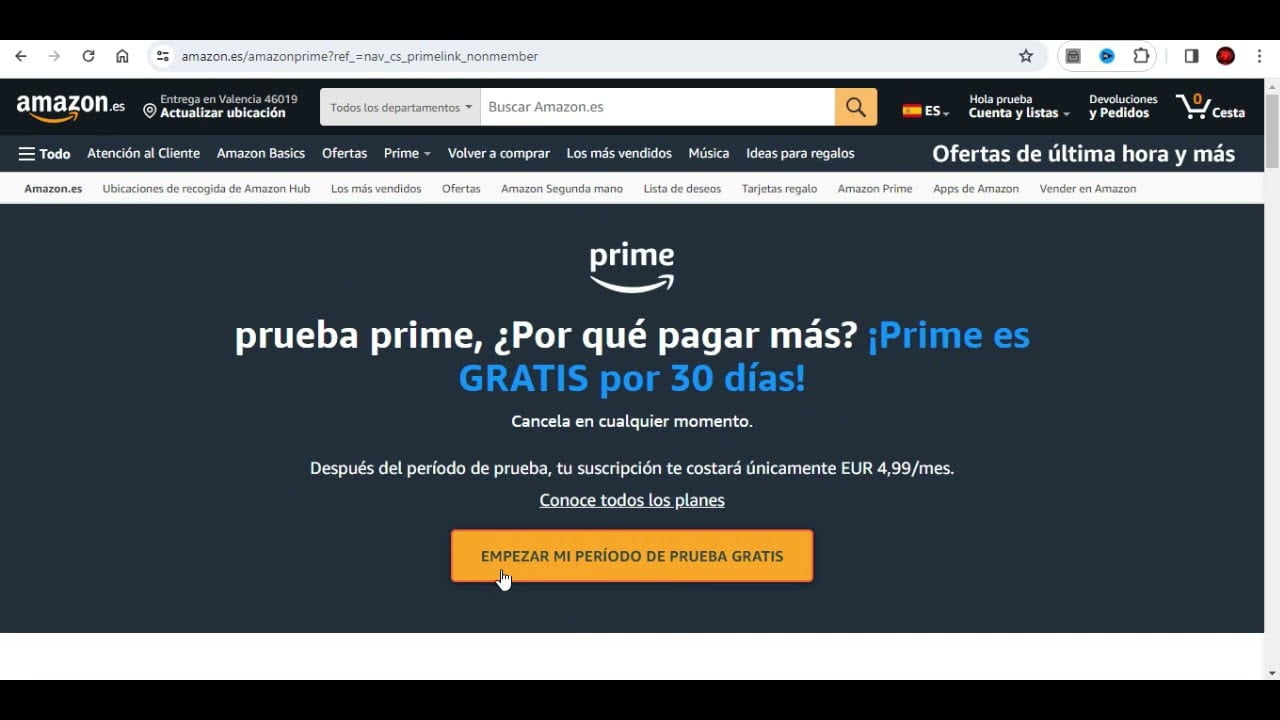

Etapa 1:Verifique qual modelo realmente produziu a última resposta. No ChatGPT, veja abaixo do cabeçalho da mensagem ou nas informações da conversa para confirmar se as respostas vieram de uma rota GPT‑5 rápida ou de uma rota de raciocínio. Durante a implementação, falhas de roteamento enviaram consultas para um modelo mais superficial; verificar o modelo ativo evita atribuições incorretas.

Etapa 2:Selecione explicitamenteGPT‑5 (thinking)para tarefas de análise pesada, como pesquisa, planejamento em várias etapas e depuração. Esta variante troca um pouco de latência por um raciocínio mais forte e redução de erros de excesso de confiança, tornando as respostas mais completas e consistentes.

Etapa 3:Reverta para um modelo em bom estado para fluxos de trabalho específicos. Após a reação dos usuários, a OpenAI reintroduziu o acesso a opções mais antigas. Nas configurações do ChatGPT, procure uma opção como “Mostrar modelos legados” e inicie um novo bate-papo comGPT‑4oouo3quando o GPT‑5 parece contundente ou perde detalhes. Um novo bate-papo garante que o contexto anterior não prejudique o roteamento.

Etapa 4:Mapeie tarefas para modelos para economizar tempo. Use o GPT‑5 rápido para respostas curtas e de baixo risco;GPT‑5 (thinking)ouo3para raciocínio;GPT‑4opara um tom de conversa mais amigável. Se você precisar de uma análise de contexto longo, considere mudar para um serviço com uma janela confiável maior para essa tarefa e depois retornar ao seu fluxo de trabalho principal.

Etapa 5:Inicie uma sessão limpa após a troca. Grandes bate-papos anteriores retardam a seleção de respostas e podem causar “desvios de contexto”. Um novo thread reduz o ruído e melhora o foco na tarefa atual.

Método 2: Forçar o raciocínio e estabilizar os resultados

Etapa 1:Na IU, escolha a variante de raciocínio. Se você vir uma opção de “pensamento” para GPT‑5, selecione-a antes de fazer perguntas complexas. Os usuários relataram respostas curtas e superficiais quando o roteador escolheu caminhos rápidos; o caminho de raciocínio gasta mais computação na análise e normalmente corta respostas incorretas e confiantes.

Etapa 2:Defina temperatura baixa para tarefas factuais. Em ferramentas que expõem parâmetros, usetemperature=0–0.3para pesquisa, especificações e matemática para reduzir o texto especulativo e manter os resultados nítidos e verificáveis.

Etapa 3:Empurre para verificação, não para verbosidade. Adicione uma instrução como:“If information is missing or uncertain, say ‘I don’t know’ and list what’s needed.”Isso reduz o tempo perdido com respostas erradas e solicita que o modelo solicite informações específicas.

Etapa 4:Use a API para selecionar a rota de raciocínio quando disponível. Defina o modelo para uma variante capaz de raciocinar e viés para um pensamento mais longo. Padrão de exemplo:

Leitura recomendada:Microsoft traz GPT-5 e GPT OSS para AI Toolkit para VS Code

curl https://api.openai.com/v1/chat/completions

-H "Authorization: Bearer $OPENAI_API_KEY"

-H "Content-Type: application/json"

-d '{

"model": "gpt-5-thinking",

"temperature": 0.2,

"messages": [

{"role": "system", "content": "When uncertain, say ‘I don’t know’ and state what’s missing."},

{"role": "user", "content": "Analyze these three designs and choose the most robust one. Cite assumptions."}

]

}'Etapa 5:Regenere com moderação com novas restrições. Se a primeira passagem encobrir os detalhes, adicione uma única restrição como“Return a decision plus the top 3 risks and mitigations.”Evite acumular instruções vagas; uma restrição precisa melhora a qualidade da saída sem desviar o roteador do caminho.

Método 3: limpar o contexto para melhorar a confiabilidade

Etapa 1:Reduza as entradas ao mínimo necessário para a pergunta. Despejos grandes reduzem o sinal/ruído e tornam o modelo mais lento. Em vez de colar documentos completos, forneça um breve resumo e apenas os trechos exatos a serem analisados. Isso reduz respostas erradas e acelera as respostas.

Etapa 2:Segmente o trabalho longo em threads com escopo definido. Se o seu bate-papo cresceu muito, inicie um novo tópico por subtarefa (por exemplo, “resumir as descobertas”, “criar plano de teste”, “finalizar tabela”). Histórias menores e focadas preservam melhor a precisão do que uma conversa sem fim.

Etapa 3:Use um fluxo de trabalho de recuperação para grandes fontes. Indexe documentos e alimente apenas as passagens com melhor correspondência. Mesmo um padrão simples de “citar e perguntar” (colar trecho, fazer pergunta) supera o despejo de centenas de páginas de uma vez.

Etapa 4:Limites do estado. Adicione uma breve instrução como“Use only the provided excerpts. If needed details are missing, list them.”Isto evita detalhes inventados e restringe o escopo a textos verificáveis.

Etapa 5:Atualize após cerca de 100 a 150 mil tokens de idas e vindas intensas. Bate-papos prolongados podem “esquecer” decisões iniciais e tornar-se inconsistentes. Uma redefinição bloqueia conclusões anteriores e mantém as respostas posteriores alinhadas.

Método 4: Torne as sessões de codificação concretas e testáveis

Etapa 1:Forneça um mapa de repositório, não apenas um texto de erro. Cole uma árvore de arquivos compacta e as principais funções envolvidas. Exemplo:src/server/ws.ts (websocket auth), src/client/app.tsx (login flow), shared/types.ts. Esse contexto melhora drasticamente a precisão da correção em relação aos rastreamentos de pilha independentes.

Etapa 2:Peça primeiro um teste com falha. Instruir:“Write a minimal failing test that reproduces the bug, then propose the smallest fix that makes it pass.”Isso fundamenta o modelo e reduz refatoradores com escopo excessivo.

Etapa 3:Exigir um plano de aplicação concreto. Antes do código, peça uma lista de etapas como“1) Patch ws.ts auth guard, 2) Add unit test, 3) Verify reconnect, 4) Summarize risks.”Confirme o plano e deixe-o implementar. Isso elimina mudanças sinuosas.

Etapa 4:Mantenha as diferenças pequenas e isoladas. Se o modelo tentar tocar em muitos arquivos, responda com“Limit the patch to ws.ts and its test. No UI changes.”Alterações menores são mais fáceis de verificar e reverter.

Etapa 5:Feche com etapas de autoverificação. Peça para listar as verificações pós-patch (por exemplo,“Run npm test; validate reconnect; check auth error path.”). Executar essas verificações do seu lado rapidamente revela erros, sem longas idas e vindas.

Método 5: verificação de fatos e verificação cruzada de respostas de alto risco

Etapa 1:Fontes de demanda para reivindicações importantes. Adicionar:“Provide URLs for any statistics or paper findings.”Se os links estiverem faltando ou forem genéricos, peça para reafirmar a afirmação como incerta e especificar quais evidências a confirmariam.

Etapa 2:Verifique com um segundo modelo quando os resultados orientam as decisões. Uma rápida passagem de sanidade com outro modelo forte (por exemplo, um conhecido pela leitura de longo contexto ou tom cuidadoso) muitas vezes detecta leituras erradas, especialmente em resumos de pesquisas e comparações de políticas.

Etapa 3:Peça tabelas ou resultados estruturados. Para comparações de produtos e resumos de pesquisas, solicite uma tabela com colunas de seu interesse (critérios, fonte, data, advertências). Os resultados estruturados expõem as lacunas imediatamente e tornam a revisão humana mais rápida.

Etapa 4:Sinalize e corrija respostas erradas com segurança. Se o modelo argumentar sobre um ponto errado, responda com a linha específica e uma breve citação de sua fonte. Siga com“Acknowledge the error and correct the answer in one paragraph.”Isso impede as idas e vindas improdutivas.

Etapa 5:Mantenha um conjunto de testes de prompts para seu fluxo de trabalho. Execute novos modelos/rotas no mesmo conjunto pequeno (por exemplo, um problema complicado de codificação, uma tarefa de resumo longo, um item matemático). Você verá rapidamente qual combinação funciona consistentemente para você.

Opcional: quando usar alternativas

Se o GPT-5 permanecer inconsistente para uma tarefa específica, combine o trabalho com um modelo conhecido por lidar bem com ele e depois volte para todo o resto:

- Janelas de contexto longas e confiáveis: serviços que suportam entradas estáveis maiores para análise de documentos.

- Privacidade ou personalização total: modelos abertos locais ou auto-hospedados.

- Cadeias de ferramentas de codificação autônomas: ferramentas ou modelos de codificação de agente com fortes fluxos de trabalho de loop de teste.

Com o caminho certo, contexto limpo e prompts testáveis, o GPT‑5 pode fornecer resultados sólidos; quando isso não acontece, trocar de modelo para o trabalho e manter um pequeno conjunto de benchmarks pessoais economiza tempo. Ajuste uma vez, reutilize com frequência e você evitará a maioria dos resultados “desanimadores”.