Vill du att din data ska förbli privat och aldrig lämna din enhet? Cloud LLM-tjänster kommer ofta med löpande prenumerationsavgifter baserade på API-anrop. Även användare i avlägsna områden eller de med opålitliga internetanslutningar föredrar inte specifikt molntjänster. Så vad är lösningen?

Lyckligtvis kan lokala LLM-verktyg eliminera dessa kostnader och låta användare köra modeller på sin hårdvara. Verktygen behandlar även data offline så att inga externa servrar kan komma åt din information. Du får också mer kontroll över det specifika gränssnittet för ditt arbetsflöde.

I den här guiden har vi samlatgratis lokala LLM-verktygatt uppfylla alla dina villkor samtidigt som du uppfyller dina integritets-, kostnads- och prestationsbehov.

Gratis verktyg för att köra LLM lokalt på Windows 11 PC

Här är några gratis lokala LLM-verktyg som har handplockats och personligen testats.

- Jan

- LM Studio

- GPT4ALL

- Vad som helst LLM

- Att vara

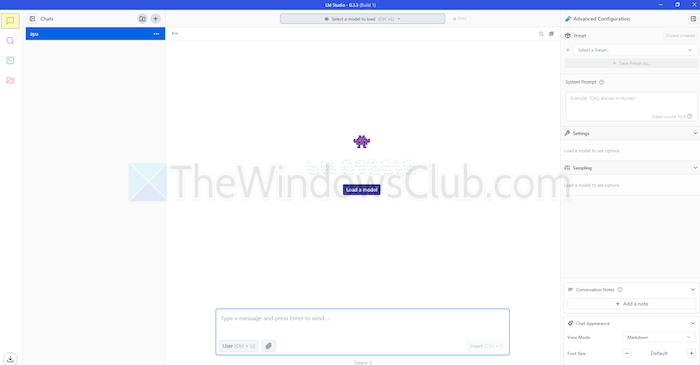

1] jan

Är du bekant med ChatGPT? I så fall är Jan en version som fungerar offline. Du kan köra den på din personliga enhet utan internet. Det låter dig generera, analysera och bearbeta textdata privat på ditt lokala nätverk.

Den kommer med förstklassiga modeller som Mistral, Nvidia eller OpenAI som du kan använda utan att skicka data till en annan server. Det här verktyget är lämpligt om du prioriteraroch vill ha ett robust alternativ till molnbaserade LLM:er.

Drag

- Förbyggda modeller:Den tillhandahåller installerade AI-modeller som är redo att användas utan ytterligare procedurer.

- Anpassning:Byt färg på instrumentbrädan och gör temat solidt eller genomskinligt.

- Stavningskontroll:Använd det här alternativet för att åtgärda stavfel.

Proffs

- Importera dina modeller med källan Hugging Face.

- Den stöder tillägg för anpassning.

- Kostnadsfritt

Nackdelar

- Mindre gemenskapsstöd Jan saknar gemenskapsstöd, och användare kan hitta färre handledningar och resurser.

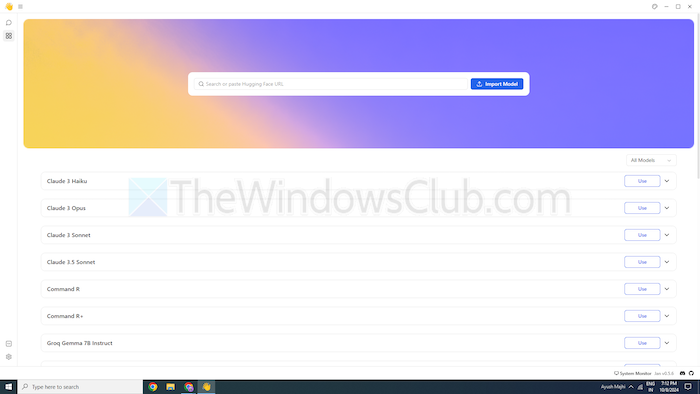

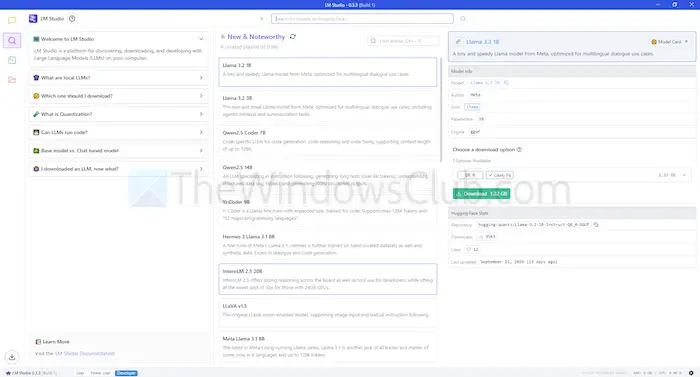

2] LM Studio

LM Studio är ett annat verktyg för att använda språkmodeller, som ChatGPT lokalt. Den erbjuder stora, förbättrade modeller för att förstå och svara på dina önskemål. Men till skillnad från molnbaserade modeller stannar du kvar på din enhet. Med andra ord, det finns mer integritet och kontroll över dess användning.

LM Studio kan sammanfatta texter, generera innehåll, svara på önskade frågor eller till och med hjälpa till med kodning, allt från din maskin. Innan du kör en modell kan du få en rapport om ditt system klarar av det. Detta låter dig spendera din tid och resurser endast på kompatibla modeller.

Drag

- Filbilagor och RAG:Du kan ladda upp PDF-, docx-, txt- och CSV-filer under chatboxen och få svar därefter.

- Omfattning av anpassning:Den erbjuder flera färgteman och låter dig välja komplexitetsnivån för gränssnittet.

- Resurstäthet:Den erbjuder gratis dokumentation och sätt att lära sig och använda verktyget.

Proffs

- Du kan använda den på Linux, Mac eller Windows.

- Lokal serverinstallation för utvecklare.

- Den erbjuder en utvald spellista med modeller

Nackdelar

- Det kan vara komplicerat att börja arbeta, speciellt för nyanlända.

3] GPT4ALL

GPT4ALL är ett annat LLM-verktyg som kan köra modeller på dina enheter utan en internetanslutning eller till och med API-integration. Det här programmet körs utan GPU:er, även om det kan utnyttja dem om det är tillgängligt, vilket gör det lämpligt för många användare. Den stöder också en rad LLM-arkitekturer, vilket gör den kompatibel med modeller och ramverk med öppen källkod.

Den använder också llama.cpp som sin backend för LLM, vilket förbättrar modellprestanda på CPU:er och GPU:er utan avancerad infrastruktur. GPT4ALL är kompatibel med både Intel- och AMD-processorer; den använder GPU:er för snabbare bearbetning.

Drag

- Lokal filinteraktion:Modeller kan fråga och interagera med lokala filer. Som PDF-filer eller textdokument, med hjälp av lokala dokument.

- Effektiv:Många modeller finns tillgängliga i 4-bitarsversioner, som använder mindre minne och bearbetning.

- Omfattande modellbibliotek:GPT4ALL har över 1000 modeller med öppen källkod från arkiv som Hugging Face.

Proffs

- Öppen källkod och Transparent

- Det erbjuder ett specifikt paket för företag att använda AI lokalt.

- GPT4ALL fokuserar starkt på integritet

Nackdelar

- Begränsat stöd för ARM-processorer som Chromebooks

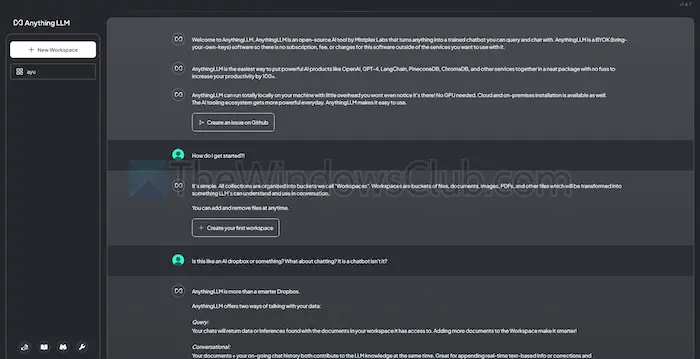

4] AnythingLLM

AnythingLLM är en öppen källkod LLM som erbjuder hög anpassning och en privat AI-upplevelse. Det låter användare distribuera och köra LLMs offline på sina lokala enheter, som Mac, Windows eller Linux, vilket säkerställer fullständig

Dessutom kommer verktyget bäst att passa enskilda användare som vill ha en lättinstallerad lösning med minimal installation. Du kan behandla det som ett privat CharGPT-liknande system som företag eller privatpersoner kan köra.

Drag

- Utvecklarvänlig:Den har ett komplett API för anpassad integration.

- Verktygsintegration:Du kan integrera ytterligare verktyg och generera API-nycklar.

- Enkel installation:Den har en installationsprocess med ett klick.

Proffs

- Flexibilitet i LLM-användning

- Dokumentcentrerad

- Plattformen har AI-agenter för att automatisera uppgifter

Nackdelar

- Saknar stöd för flera användare

- Komplexitet i avancerade funktioner

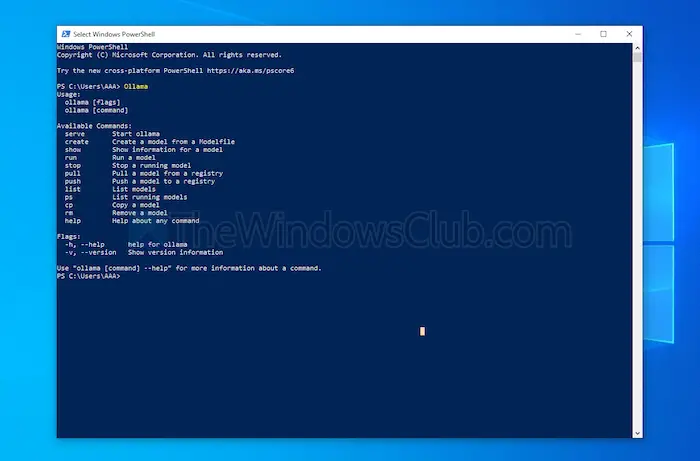

5] Att vara

Ollama ger full kontroll över att skapa lokala chatbots utan API. För närvarande har den de viktigaste bidragsgivarna som tillhandahåller frekventa uppdateringar och förbättrar den övergripande funktionaliteten hos GitHub. Detta uppdaterar det här verktyget och ger bättre prestanda än andra. Till skillnad från de andra verktygen som diskuterats ovan, öppnar det ett terminalgränssnitt för att installera och starta en modell.

Varje modell du installerar har sina egna konfigurationer och vikter, vilket undviker konflikter med annan programvara på din maskin. Tillsammans med kommandoradsgränssnittet har Ollama ett API som är kompatibelt med OpenAI. Du kan enkelt integrera detta verktyg med ett som använder OpenAI-modeller.

Drag

- Lokal distribution:Ollama låter dig köra stora språkmodeller offline, som Llama, Mistral eller andra.

- Modellanpassning:Avancerade användare kan ställa in beteende i modeller med hjälp av en Modefile.

- OpenAI API-kompatibilitet:Den har ett REST API som är kompatibelt med OpenAIs API.

- Resurshantering:Det optimerar CPU- och GPU-användning, utan att överbelasta systemet.

Proffs

- Du kan få en samling modeller.

- Den kan importera modeller från bibliotek med öppen källkod som PyTorch.

- Ollama kan integreras med ett enormt biblioteksstöd

Nackdelar

- Det ger inte ett grafiskt användargränssnitt

- Kräver stora lagringskrav

Slutsats

Sammanfattningsvis erbjuder lokala LLM-verktyg ett värdigt alternativ till molnbaserade modeller. De erbjuder integritet och kontroll på nästa nivå utan kostnad. Oavsett om du strävar efter användarvänlighet eller anpassning, erbjuder verktygen som listas en mängd olika behov och expertisnivåer.

Beroende på dina behov, såsom processorkraft och kompatibilitet, kan någon av dessa utnyttja AI:s potential utan att kompromissa med integriteten eller kräva prenumerationsavgifter.

![Startappar visas inte i appen Inställningar i Windows 11 [Fix]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/12/startup-not-showing-settings-windows-11.png)