¿Quieres que tus datos permanezcan privados y nunca salgan de tu dispositivo? Los servicios de LLM en la nube a menudo vienen con tarifas de suscripción continuas basadas en llamadas API. Incluso los usuarios de áreas remotas o aquellos con conexiones a Internet poco confiables no prefieren específicamente los servicios en la nube. Entonces ¿cuál es la solución?

Afortunadamente, las herramientas LLM locales pueden eliminar estos costos y permitir a los usuarios ejecutar modelos en su hardware. Las herramientas también procesan datos fuera de línea para que ningún servidor externo pueda acceder a su información. También obtendrá más control sobre la interfaz específica de su flujo de trabajo.

En esta guía, hemos reunido losHerramientas LLM locales gratuitaspara cumplir con todas sus condiciones y al mismo tiempo satisfacer sus necesidades de privacidad, costos y rendimiento.

A continuación se muestran algunas herramientas LLM locales gratuitas que han sido seleccionadas cuidadosamente y probadas personalmente.

- Ene

- Estudio LM

- GPT4ALL

- Cualquier cosa LLM

- Ser

1] enero

¿Estás familiarizado con ChatGPT? Si es así, Jan es una versión que funciona sin conexión. Puede ejecutarlo en su dispositivo personal sin Internet. Le permite generar, analizar y procesar datos de texto de forma privada en su red local.

Viene con modelos de primer nivel como Mistral, Nvidia u OpenAI que puedes usar sin enviar datos a otro servidor. Esta herramienta es adecuada si priorizasy desea una alternativa sólida a los LLM basados en la nube.

Características

- Modelos preconstruidos:Proporciona modelos de IA instalados que están listos para usar sin procedimientos adicionales.

- Personalización:Cambie el color del tablero y haga que el tema sea sólido o translúcido.

- Revisión ortográfica:Utilice esta opción para corregir los errores ortográficos.

Ventajas

- Importa tus modelos usando la fuente Hugging Face.

- Admite extensiones para personalización.

- Gratis sin costo

Contras

- Menos soporte comunitario Jan carece de soporte comunitario y los usuarios pueden encontrar menos tutoriales y recursos.

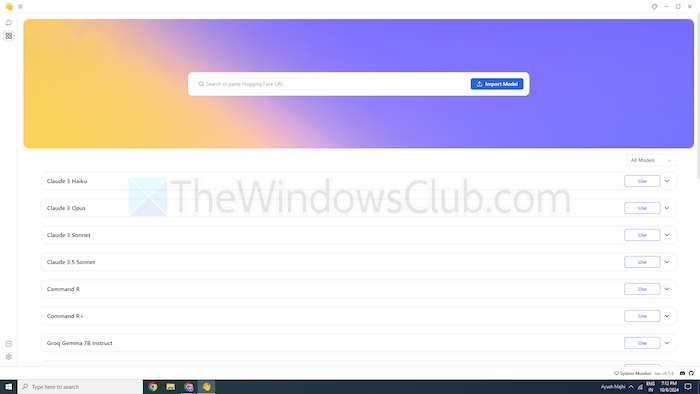

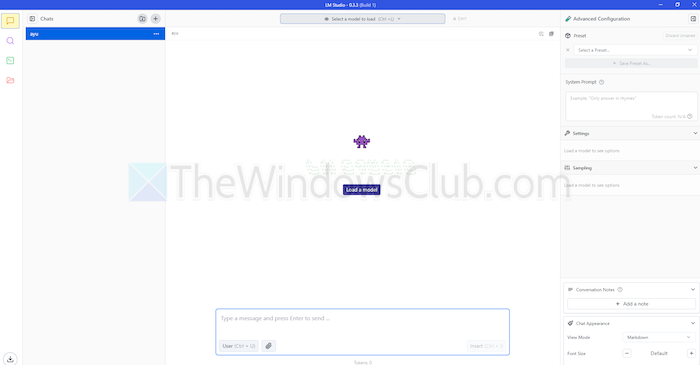

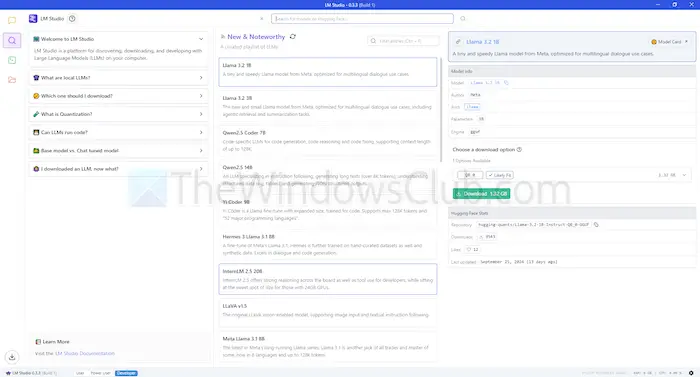

2]Estudio LM

LM Studio es otra herramienta para utilizar modelos de lenguaje, como ChatGPT localmente. Ofrece modelos grandes y mejorados para comprender y responder a sus solicitudes. Pero, a diferencia de los modelos basados en la nube, usted permanece en su dispositivo. En otras palabras, hay más privacidad y control sobre su uso.

LM Studio puede resumir textos, generar contenido, responder las preguntas que desee o incluso ayudar con la codificación, todo desde su máquina. Antes de ejecutar un modelo, puede obtener un informe sobre si su sistema puede manejarlo. Esto le permite dedicar su tiempo y recursos sólo a modelos compatibles.

Características

- Archivos adjuntos y RAG:Puede cargar archivos PDF, docx, txt y CSV en el cuadro de chat y obtener las respuestas correspondientes.

- Rango de personalización:Ofrece múltiples temas de colores y te permite elegir el nivel de complejidad de la interfaz.

- Denso en recursos:Ofrece documentación gratuita y formas de aprender y utilizar la herramienta.

Ventajas

- Puedes usarlo en Linux, Mac o Windows.

- Configuración de servidor local para desarrolladores.

- Ofrece una lista de reproducción seleccionada de modelos.

Contras

- Puede resultar complejo empezar a trabajar, especialmente para los recién llegados.

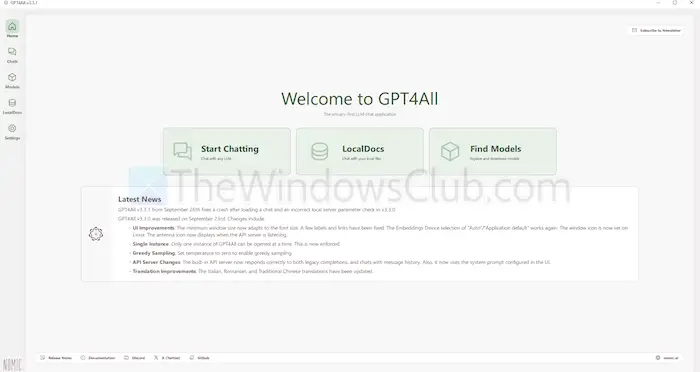

3]GPT4ALL

GPT4ALL es otra herramienta LLM que puede ejecutar modelos en sus dispositivos sin conexión a Internet o incluso integración API. Este programa se ejecuta sin GPU, aunque puede aprovecharlas si están disponibles, lo que lo hace adecuado para muchos usuarios. También admite una variedad de arquitecturas LLM, lo que lo hace compatible con modelos y marcos de código abierto.

También utiliza llama.cpp como backend para LLM, lo que mejora el rendimiento del modelo en CPU y GPU sin infraestructura de alta gama. GPT4ALL es compatible con procesadores Intel y AMD; Utiliza GPU para un procesamiento más rápido.

Características

- Interacción de archivos locales:Los modelos pueden consultar e interactuar con archivos locales. Como archivos PDF o documentos de texto, utilizando Local Docs.

- Eficiente:Muchos modelos están disponibles en versiones de 4 bits, que utilizan menos memoria y procesamiento.

- Amplia biblioteca de modelos:GPT4ALL tiene más de 1000 modelos de código abierto de repositorios como Hugging Face.

Ventajas

- De código abierto y transparente

- Ofrece un paquete específico para que las empresas utilicen la IA localmente.

- GPT4ALL se centra fuertemente en la privacidad

Contras

- Soporte limitado para procesadores ARM como Chromebooks

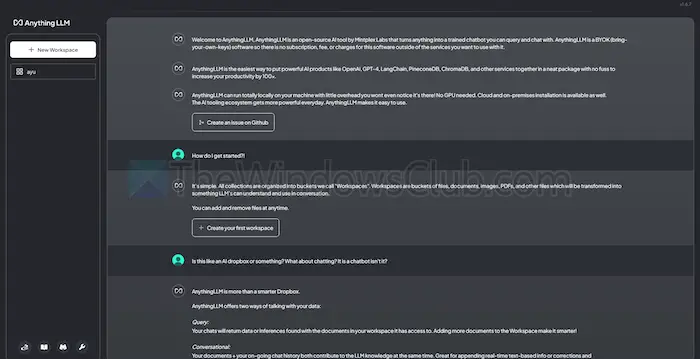

4]Cualquier cosaLLM

AnythingLLM es un LLM de código abierto que ofrece alta personalización y una experiencia de IA privada. Permite a los usuarios implementar y ejecutar LLM sin conexión en sus dispositivos locales, como Mac, Windows o Linux, asegurando una completa

Además, la herramienta se adapta mejor a los usuarios individuales que desean una solución fácil de instalar con una configuración mínima. Puede tratarlo como un sistema privado similar a CharGPT que pueden ejecutar empresas o individuos.

Características

- Fácil de usar para desarrolladores:Tiene una API completa para integración personalizada.

- Integración de herramientas:Puede integrar herramientas adicionales y generar claves API.

- Configuración sencilla:Tiene un proceso de instalación con un solo clic.

Ventajas

- Flexibilidad en el uso de LLM

- Centrado en documentos

- La plataforma cuenta con agentes de IA para automatizar tareas

Contras

- Carece de soporte multiusuario

- Complejidad en funciones avanzadas

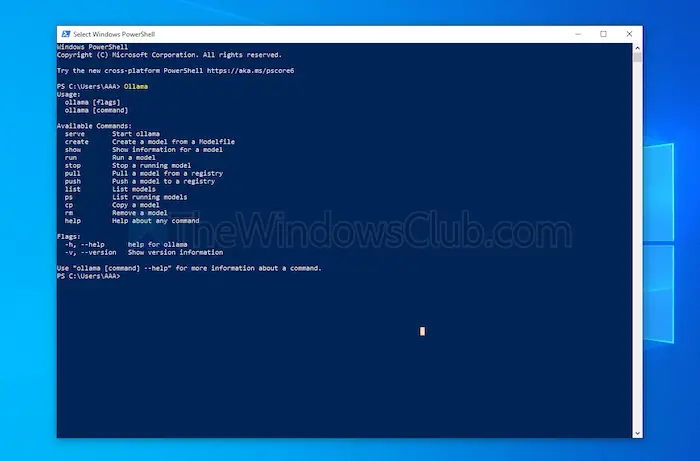

5] Ser

Ollama brinda control total sobre la creación de chatbots locales sin API. Actualmente, cuenta con los contribuyentes más importantes que brindan actualizaciones frecuentes y mejoran la funcionalidad general de GitHub. Esto actualiza esta herramienta y proporciona un mejor rendimiento que otras. A diferencia de las otras herramientas mencionadas anteriormente, abre una interfaz de terminal para instalar e iniciar un modelo.

Cada modelo que instales tiene sus propias configuraciones y pesos, evitando conflictos con otro software de tu máquina. Junto con su interfaz de línea de comandos, Ollama cuenta con una API compatible con OpenAI. Puede integrar fácilmente esta herramienta con una que utilice modelos OpenAI.

Características

- Despliegue local:Ollama le permite ejecutar grandes modelos de lenguaje sin conexión, como Llama, Mistral u otros.

- Personalización del modelo:Los usuarios avanzados pueden establecer el comportamiento en los modelos utilizando un Modefile.

- Compatibilidad de la API OpenAI:Tiene una API REST compatible con la API de OpenAI.

- Gestión de recursos:Optimiza el uso de CPU y GPU, sin sobrecargar el sistema.

Ventajas

- Puedes conseguir una colección de modelos.

- Puede importar modelos de bibliotecas de código abierto como PyTorch.

- Ollama puede integrarse con un tremendo soporte de biblioteca

Contras

- No proporciona una interfaz gráfica de usuario.

- Requiere grandes requisitos de almacenamiento.

Conclusión

En resumen, las herramientas locales de LLM ofrecen una valiosa alternativa a los modelos basados en la nube. Ofrecen privacidad y control de nivel superior sin costo alguno. Ya sea que busque facilidad de uso o personalización, las herramientas enumeradas ofrecen una variedad de necesidades y niveles de experiencia.

Dependiendo de sus necesidades, como la potencia de procesamiento y la compatibilidad, cualquiera de ellas puede aprovechar el potencial de la IA sin comprometer la privacidad ni requerir tarifas de suscripción.