Το Llama 3 είναι το πιο πρόσφατο μοντέλο μεγάλης γλώσσας της Meta. Μπορείτε να το χρησιμοποιήσετε για διάφορους σκοπούς, όπως επίλυση των αποριών σας, λήψη βοήθειας με τις σχολικές εργασίες και τα έργα σας κ.λπ. Η ανάπτυξη του Llama 3 στον υπολογιστή σας Windows 11 τοπικά θα σας βοηθήσει να το χρησιμοποιήσετε ανά πάσα στιγμή, ακόμη και χωρίς πρόσβαση στο διαδίκτυο. Αυτό το άρθρο σας δείχνειπώς να εγκαταστήσετε το Llama 3 σε υπολογιστή με Windows 11.

Πώς να εγκαταστήσετε το Llama 3 σε υπολογιστή με Windows 11

Η εγκατάσταση του Llama 3 σε υπολογιστή με Windows 11 μέσω Python απαιτεί τεχνικές δεξιότητες και γνώσεις. Ωστόσο, ορισμένες εναλλακτικές μέθοδοι σάς επιτρέπουν να αναπτύξετε τοπικά το Llama 3 στον υπολογιστή σας με Windows 11. Θα σας δείξω αυτές τις μεθόδους.

Για να εγκαταστήσετε το Llama 3 στον υπολογιστή σας με Windows 11, πρέπει να εκτελέσετε ορισμένες εντολές στη γραμμή εντολών. Ωστόσο, αυτό θα σας επιτρέψει μόνο να χρησιμοποιήσετε την έκδοση γραμμής εντολών. Πρέπει να κάνετε περαιτέρω βήματα εάν θέλετε να χρησιμοποιήσετε τη διεπαφή ιστού του. Θα σας δείξω και τις δύο αυτές μεθόδους.

Αναπτύξτε το Llama 3 σε υπολογιστή Windows 11 μέσω CMD

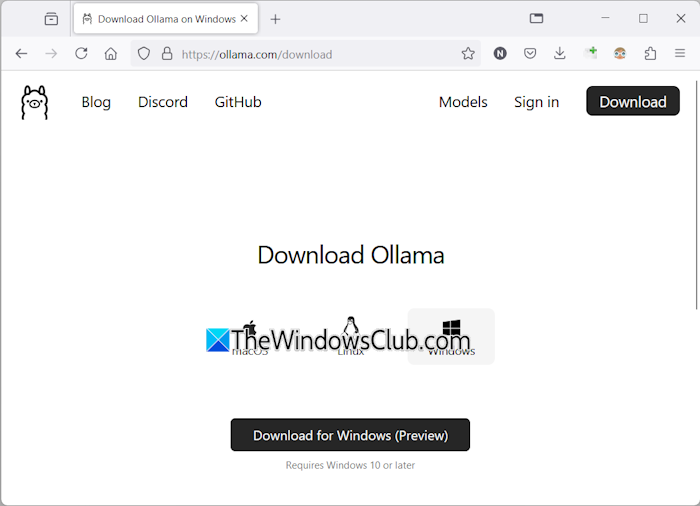

Για να αναπτύξετε το Llama 3 στον υπολογιστή σας με Windows 11, πρέπει να εγκαταστήσετε το Ollama στον υπολογιστή σας με Windows. Τα βήματα για το ίδιο είναι τα εξής:

- ΕπίσκεψηΟ επίσημος ιστότοπος του Ollama.

- Κάντε κλικ στοΛήψηκουμπί και μετά επιλέξτεWindows.

- Τώρα, κάντε κλικ στοΛήψη για Windowsκουμπί για να αποθηκεύσετε το αρχείο exe στον υπολογιστή σας.

- Εκτελέστε το αρχείο exe για να εγκαταστήσετε το Olama στον υπολογιστή σας.

Μόλις εγκατασταθεί το Ollama στη συσκευή σας, επανεκκινήστε τον υπολογιστή σας. Θα πρέπει να εκτελείται στο παρασκήνιο. Μπορείτε να το δείτε στο System Tray. Τώρα, κάντε κλικ στην επιλογή Μοντέλα στον ιστότοπο της Olama. Θα δείτε τα διαφορετικά μοντέλα του.

Το Llama 3.1 είναι διαθέσιμο στις ακόλουθες τρεις παραμέτρους:

- 8Β

- 70Β

- 405Β

Η τελευταία είναι η μεγαλύτερη παράμετρος και προφανώς δεν μπορεί να εκτελεστεί σε υπολογιστή χαμηλού επιπέδου. Το Llama 3.2 έχει τις ακόλουθες δύο παραμέτρους:

- 1Β

- 3Β

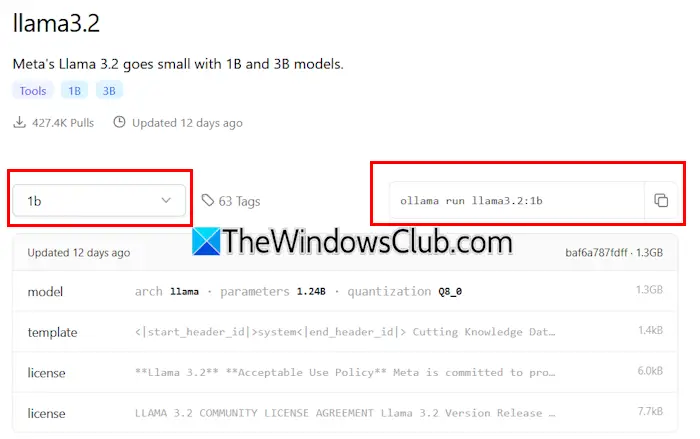

Κάντε κλικ στην έκδοση Llama που θέλετε να εγκαταστήσετε στον υπολογιστή σας. Για παράδειγμα, εάν θέλετε να εγκαταστήσετε το Llama 3.2, κάντε κλικ στο Llama 3.2. Στο αναπτυσσόμενο μενού, μπορείτε να επιλέξετε την παράμετρο που θέλετε να εγκαταστήσετε. Μετά από αυτό, αντιγράψτε την εντολή δίπλα της και επικολλήστε την στη γραμμή εντολών.

Για τη διευκόλυνσή σας, έχω γράψει και τις δύο εντολές για το μοντέλο Llama 3.2. Για να εγκαταστήσετε το μοντέλο Llama 3.2 3B, εκτελέστε την ακόλουθη εντολή:

ollama run llama3.2:3b

Για να εγκαταστήσετε το μοντέλο Llama 3.2 1B, χρησιμοποιήστε την ακόλουθη εντολή:

ollama run llama3.2:1b

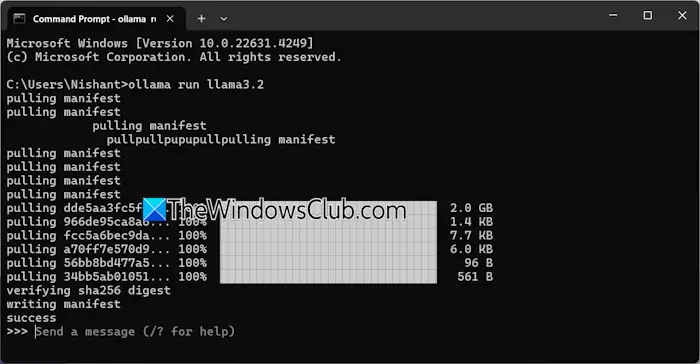

Ανοίξτε τη Γραμμή εντολών, πληκτρολογήστε οποιαδήποτε από τις παραπάνω εντολές (με βάση τις απαιτήσεις σας) και πατήστεΕισάγω. Θα χρειαστεί λίγος χρόνος για τη λήψη των απαιτούμενων αρχείων. Ο χρόνος λήψης θα εξαρτηθεί επίσης από την ταχύτητα της σύνδεσής σας στο Διαδίκτυο. Μετά την ολοκλήρωση, θα δείτε τοεπιτυχίαμήνυμα στη γραμμή εντολών.

Τώρα, πληκτρολογήστε το μήνυμά σας για να χρησιμοποιήσετε το μοντέλο Llama 3.2. Εάν θέλετε να εγκαταστήσετε το μοντέλο Llama 3.1, χρησιμοποιήστε τις εντολές που είναι διαθέσιμες στον ιστότοπο της Ollama.

Την επόμενη φορά που θα εκκινήσετε τη γραμμή εντολών, χρησιμοποιήστε την ίδια εντολή για να εκτελέσετε το Llama 3.1 ή 3.2 στον υπολογιστή σας.

Η εγκατάσταση του Llama 3 μέσω CMD έχει ένα μειονέκτημα. Δεν αποθηκεύει το ιστορικό συνομιλιών σας. Ωστόσο, εάν το αναπτύξετε στον τοπικό κεντρικό υπολογιστή, το ιστορικό συνομιλιών σας θα αποθηκευτεί και θα έχετε καλύτερη διεπαφή χρήστη. Η επόμενη μέθοδος δείχνει πώς να το κάνετε αυτό.

Αναπτύξτε το Llama 3 Web UI στα Windows 11

Η χρήση του Llama 3 σε ένα πρόγραμμα περιήγησης ιστού παρέχει καλύτερη διεπαφή χρήστη και επίσης αποθηκεύει το ιστορικό συνομιλιών σε σύγκριση με τη χρήση του στο παράθυρο CMD. Θα σας δείξω πώς να αναπτύξετε το Llama 3 στο πρόγραμμα περιήγησής σας.

Για να χρησιμοποιήσετε το Llama 3 στο πρόγραμμα περιήγησής σας στον ιστό, το Llama 3 μέσω Ollama και το Docker θα πρέπει να είναι εγκατεστημένο στο σύστημά σας. Εάν δεν έχετε εγκαταστήσει ακόμα το Llama 3, εγκαταστήστε το χρησιμοποιώντας το Ollama (όπως εξηγήθηκε παραπάνω). Τώρα, κατεβάστε και εγκαταστήστε το Docker από τοεπίσημη ιστοσελίδα.

Αφού εγκαταστήσετε το Docker, ξεκινήστε το και εγγραφείτε για να δημιουργήσετε έναν λογαριασμό. Το Docker δεν θα τρέξει μέχρι να εγγραφείτε. Αφού εγγραφείτε, συνδεθείτε στον λογαριασμό σας στην εφαρμογή Docker. Ελαχιστοποιήστε το Docker στο System Tray. Οι εφαρμογές Docker και Olama θα πρέπει να εκτελούνται στο παρασκήνιο. Διαφορετικά, δεν μπορείτε να χρησιμοποιήσετε το Llama 3 στο πρόγραμμα περιήγησής σας.

Τώρα, ανοίξτε τη γραμμή εντολών, αντιγράψτε την ακόλουθη εντολή και επικολλήστε την στη γραμμή εντολών:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

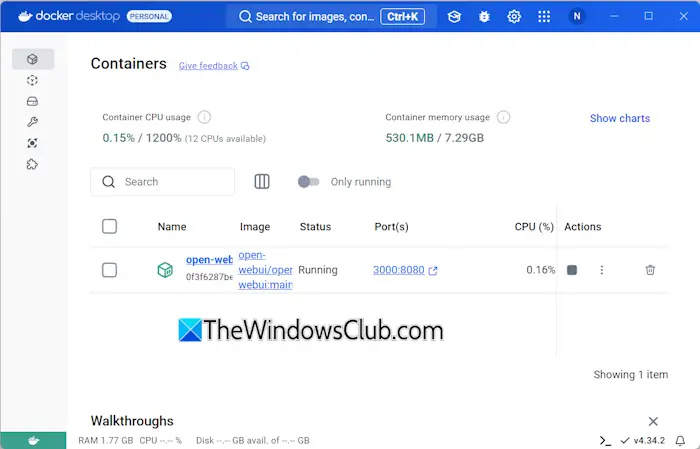

Η παραπάνω εντολή θα χρειαστεί λίγο χρόνο για τη λήψη των απαιτούμενων πόρων. Επομένως, κάντε λίγη υπομονή. Μετά την ολοκλήρωση της εντολής, ανοίξτε το Docker και επιλέξτε τοΕμπορευματοκιβώτιατμήμα από την αριστερή πλευρά. Θα δείτε ότι ένα κοντέινερ δημιουργείται αυτόματα με τη θύρα 3000:8080.

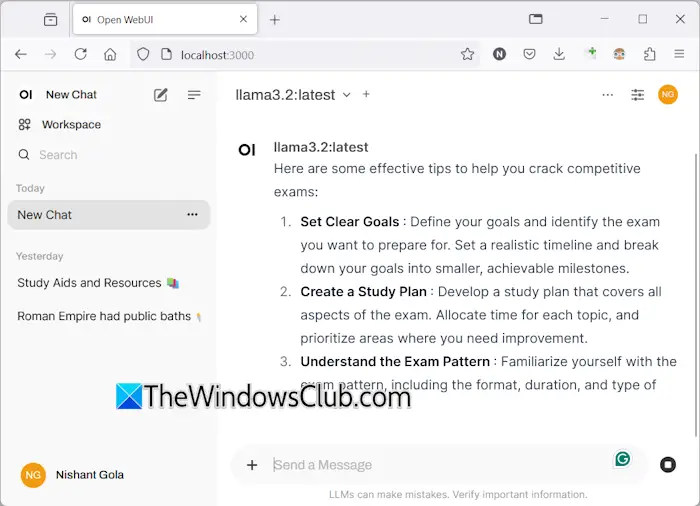

Κάντε κλικ στη θύρα 3000:8080. Αυτό θα ανοίξει μια νέα καρτέλα στο προεπιλεγμένο πρόγραμμα περιήγησής σας. Τώρα, εγγραφείτε και συνδεθείτε για να χρησιμοποιήσετε το Llama 3 στο πρόγραμμα περιήγησής σας. Αν δείτε τη γραμμή διευθύνσεων, θα δείτεlocalhost: 3000εκεί, πράγμα που σημαίνει ότι το Llama 3 φιλοξενείται τοπικά στον υπολογιστή σας. Μπορείτε να το χρησιμοποιήσετε χωρίς σύνδεση στο διαδίκτυο.

Επιλέξτε το μοντέλο συνομιλίας Llama από το αναπτυσσόμενο μενού. Εάν θέλετε να προσθέσετε περισσότερα μοντέλα συνομιλίας του Llama 3, πρέπει να το εγκαταστήσετε μέσω του Ollama χρησιμοποιώντας τις απαιτούμενες εντολές. Μετά από αυτό, το μοντέλο θα είναι αυτόματα διαθέσιμο στο πρόγραμμα περιήγησής σας.

Όλο το ιστορικό συνομιλιών σας θα αποθηκευτεί και θα είναι προσβάσιμο στην αριστερή πλευρά. Όταν θέλετε να πραγματοποιήσετε έξοδο, αποσυνδεθείτε από τη συνεδρία σας στο πρόγραμμα περιήγησής σας. Μετά από αυτό, ανοίξτε την εφαρμογή Docker και κάντε κλικ στοΣτάσηκουμπί για να σταματήσει το Docker. Τώρα, μπορείτε να κλείσετε το Docker.

Όταν θέλετε να χρησιμοποιήσετε το Llama 3 στο πρόγραμμα περιήγησής σας την επόμενη φορά, εκκινήστε το Ollama και το Docker, περιμένετε μερικά λεπτά και, στη συνέχεια, κάντε κλικ στη θύρα στο κοντέινερ Docker για να ανοίξετε τον διακομιστή localhost στο πρόγραμμα περιήγησής σας. Τώρα, συνδεθείτε στον λογαριασμό σας και αρχίστε να χρησιμοποιείτε το Llama 3.

Ελπίζω αυτό να βοηθήσει.

Μπορεί το Llama 3 να τρέχει σε Windows;

Ανάλογα με τη διαμόρφωση υλικού του υπολογιστή σας, μπορείτε να εκτελέσετε το Llama 3 στο σύστημά σας. Το μοντέλο 1B του είναι το ελαφρύτερο. Μπορείτε να το εγκαταστήσετε και να το εκτελέσετε στο σύστημά σας μέσω της γραμμής εντολών.

Πόση μνήμη RAM χρειάζομαι για το Llama 3;

Το ελαφρύτερο μοντέλο του Llama 3 είναι το Llama 3.2 1B. Το σύστημά σας θα πρέπει να έχει 16 GB μνήμης RAM για την εκτέλεση του μοντέλου Llama 3.2 1B. Εκτός από αυτό, το σύστημά σας θα πρέπει επίσης να διαθέτει GPU βαρέως τύπου. Τα υψηλότερα μοντέλα του Llama 3 απαιτούν περισσότερους πόρους συστήματος.

Διαβάστε στη συνέχεια:.