W dzisiejszych czasach rozwój AI od czasu do czasu obejmuje porównania z innymi modelami. Ostatnio doniesiono, że Google może używać konkurencyjnego modelu Claude'a w celu poprawy bezpieczeństwa własnego modelu.

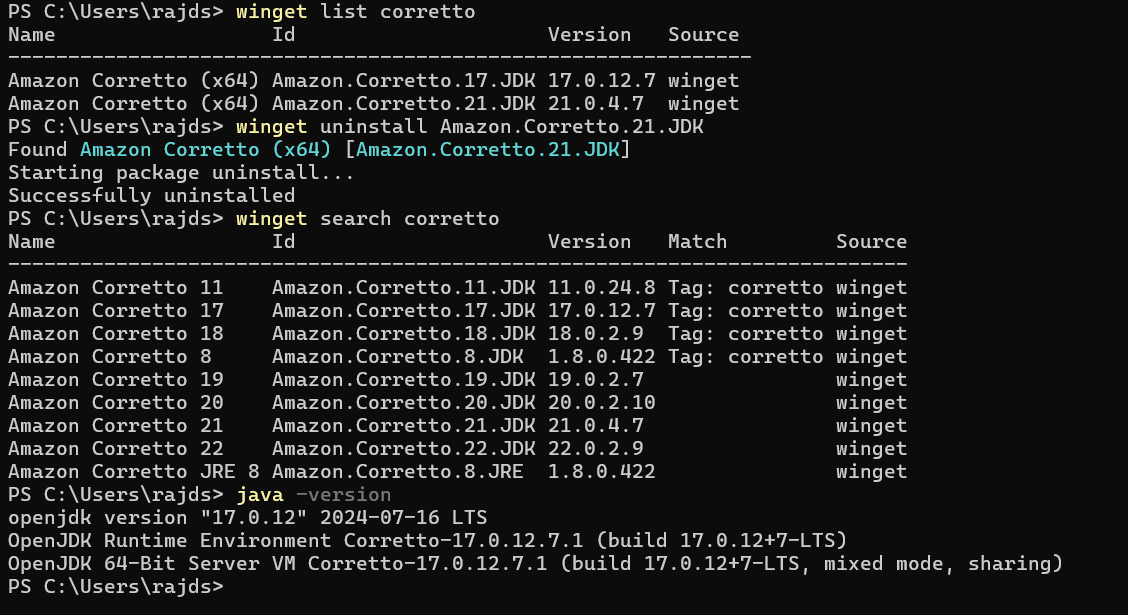

TechCrunch donosi, że Google zlewa outsourcera do porównania wyników Gemini z Claude'em. Ocena każdego zestawu odpowiedzi zajmuje do 30 minut do 30 minut, a raport zacytował z outsourcingu persone . ”

Według pracownika outsourcingowego Claude przewyższył Gemini pod względem bezpieczeństwa i że Claude odmówił odpowiedzi na niebezpieczne podpowiedzi, takie jak odgrywanie ról, i że Gemini miał nieodpowiednią treść do pewnych podpowiedzi. Podczas gdy Google jest jednym z głównych inwestorów antropików, warunki usług antropic wyraźnie zabraniają nielicencjonowanego wykorzystania Claude'a do opracowywania konkurencyjnych produktów lub szkolenia konkurujących modeli AI.

Rzecznik Google Deepmind Shira McNamara przyznał, że rzeczywiście porównują wyniki modelu AI, ale odmówili używania Claude'a do szkolenia Gemini, ale nie odpowiedziała na to, czy byli oni licencjonowani przez antropic na porównanie wyjściowe.