Czy chcesz, aby Twoje dane pozostały prywatne i nigdy nie opuszczały Twojego urządzenia? Usługi Cloud LLM często wiążą się z bieżącymi opłatami subskrypcyjnymi opartymi na wywołaniach API. Nawet użytkownicy z odległych obszarów lub z zawodnymi połączeniami internetowymi nie preferują usług w chmurze. Jakie jest więc rozwiązanie?

Na szczęście lokalne narzędzia LLM mogą wyeliminować te koszty i umożliwić użytkownikom uruchamianie modeli na ich sprzęcie. Narzędzia przetwarzają również dane w trybie offline, dzięki czemu żadne zewnętrzne serwery nie mają dostępu do Twoich informacji. Uzyskasz także większą kontrolę nad interfejsem dostosowanym do Twojego przepływu pracy.

W tym przewodniku zebraliśmybezpłatne lokalne narzędzia LLMaby spełnić wszystkie Twoje warunki, jednocześnie spełniając Twoje potrzeby w zakresie prywatności, kosztów i wydajności.

Oto kilka bezpłatnych, lokalnych narzędzi LLM, które zostały starannie wybrane i osobiście przetestowane.

- styczeń

- Studio LM

- GPT4ALL

- Cokolwiek LLM

- Być

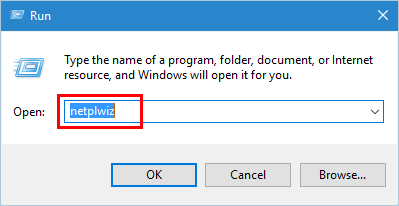

1] styczeń

Czy znasz ChatGPT? Jeśli tak, Jan jest wersją działającą w trybie offline. Możesz uruchomić go na swoim urządzeniu osobistym bez Internetu. Umożliwia prywatne generowanie, analizowanie i przetwarzanie danych tekstowych w sieci lokalnej.

Zawiera najwyższej klasy modele, takie jak Mistral, Nvidia czy OpenAI, z których można korzystać bez wysyłania danych na inny serwer. To narzędzie jest odpowiednie, jeśli ustalasz priorytetyi chcą solidnej alternatywy dla LLM opartych na chmurze.

Cechy

- Gotowe modele:Udostępnia zainstalowane modele AI, które są gotowe do użycia bez dodatkowych procedur.

- Personalizacja:Zmień kolor pulpitu nawigacyjnego i spraw, aby motyw był jednolity lub półprzezroczysty.

- Sprawdzanie pisowni:Użyj tej opcji, aby poprawić błędy ortograficzne.

Plusy

- Zaimportuj swoje modele, korzystając ze źródła Hugging Face.

- Obsługuje rozszerzenia umożliwiające personalizację.

- Bezpłatnie

Wady

- Mniej wsparcia społeczności Janowi brakuje wsparcia społeczności, a użytkownicy mogą znaleźć mniej samouczków i zasobów.

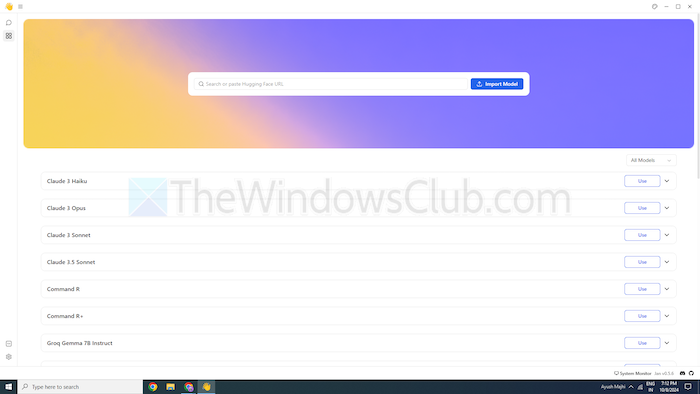

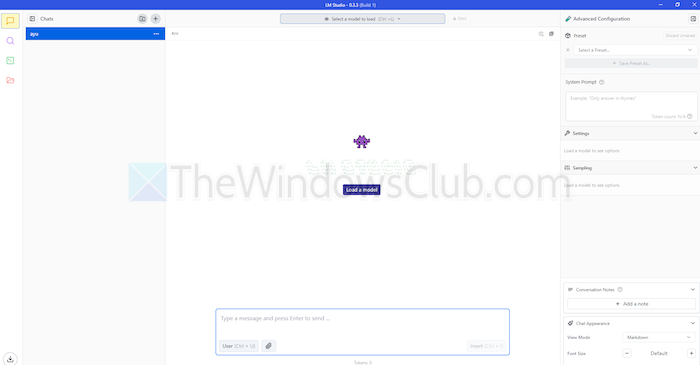

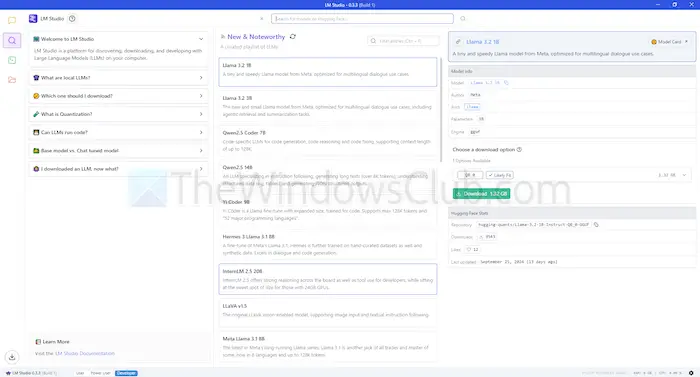

2] Studio LM

LM Studio to kolejne narzędzie do lokalnego używania modeli językowych, takich jak ChatGPT. Oferuje duże, ulepszone modele umożliwiające zrozumienie Twoich żądań i reagowanie na nie. Ale w przeciwieństwie do modeli opartych na chmurze, pozostajesz na swoim urządzeniu. Innymi słowy, istnieje większa prywatność i kontrola nad jego wykorzystaniem.

LM Studio może podsumowywać teksty, generować treści, odpowiadać na wybrane pytania, a nawet pomagać w kodowaniu, a wszystko to na Twoim komputerze. Przed uruchomieniem modelu możesz uzyskać raport na temat tego, czy Twój system sobie z nim poradzi. Dzięki temu możesz spędzać czas i zasoby tylko na kompatybilnych modelach.

Cechy

- Załączniki plików i RAG:Możesz przesyłać pliki PDF, docx, txt i CSV w oknie czatu i otrzymywać odpowiednie odpowiedzi.

- Zakres dostosowywania:Oferuje wiele motywów kolorystycznych i pozwala wybrać poziom złożoności interfejsu.

- Gęste zasoby:Oferuje bezpłatną dokumentację oraz sposoby nauki i korzystania z narzędzia.

Plusy

- Można go używać w systemie Linux, Mac i Windows.

- Konfiguracja serwera lokalnego dla programistów.

- Oferuje wyselekcjonowaną playlistę Modeli

Wady

- Rozpoczęcie pracy może być skomplikowane, szczególnie dla nowicjuszy.

3] GPT4ALL

GPT4ALL to kolejne narzędzie LLM, które może uruchamiać modele na Twoich urządzeniach bez połączenia z Internetem, a nawet integracji API. Ten program działa bez procesorów graficznych, chociaż może je wykorzystać, jeśli są dostępne, co czyni go odpowiednim dla wielu użytkowników. Obsługuje również szereg architektur LLM, co czyni go kompatybilnym z modelami i frameworkami typu open source.

Wykorzystuje również llama.cpp jako zaplecze dla LLM, co poprawia wydajność modelu na procesorach i procesorach graficznych bez zaawansowanej infrastruktury. GPT4ALL jest kompatybilny zarówno z procesorami Intel, jak i AMD; wykorzystuje procesory graficzne do szybszego przetwarzania.

Cechy

- Lokalna interakcja z plikami:Modele mogą wysyłać zapytania i wchodzić w interakcje z plikami lokalnymi. Podobnie jak pliki PDF lub dokumenty tekstowe, korzystając z Dokumentów lokalnych.

- Wydajny:Wiele modeli jest dostępnych w wersjach 4-bitowych, które zużywają mniej pamięci i przetwarzania.

- Rozbudowana biblioteka modeli:GPT4ALL ma ponad 1000 modeli open source z repozytoriów takich jak Hugging Face.

Plusy

- Otwarte i przejrzyste

- Oferuje specyficzny pakiet dla przedsiębiorstw umożliwiający lokalne wykorzystanie sztucznej inteligencji.

- GPT4ALL mocno skupia się na prywatności

Wady

- Ograniczona obsługa procesorów ARM, takich jak Chromebooki

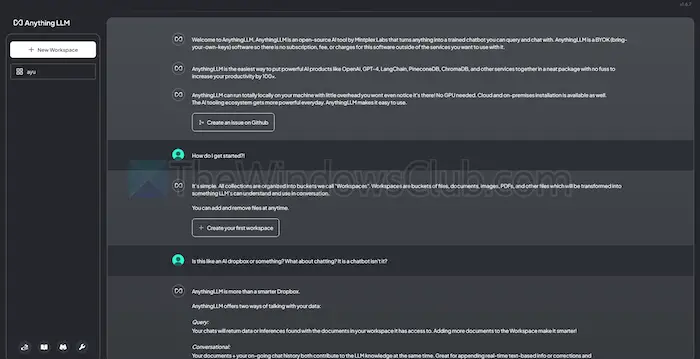

4] WszystkoLLM

EverythingLLM to oprogramowanie LLM o otwartym kodzie źródłowym, które oferuje wysoki poziom dostosowywania i prywatne wrażenia ze sztucznej inteligencji. Umożliwia użytkownikom wdrażanie i uruchamianie LLM w trybie offline na urządzeniach lokalnych, takich jak Mac, Windows lub Linux, zapewniając kompletność

Co więcej, narzędzie będzie najlepiej odpowiadać pojedynczym użytkownikom, którzy chcą łatwego w instalacji rozwiązania przy minimalnej konfiguracji. Można go traktować jako prywatny system podobny do CharGPT, który mogą prowadzić firmy lub osoby prywatne.

Cechy

- Przyjazny dla programistów:Posiada kompletny interfejs API do niestandardowej integracji.

- Integracja narzędzi:Możesz zintegrować dodatkowe narzędzia i wygenerować klucze API.

- Łatwa konfiguracja:Ma proces instalacji jednym kliknięciem.

Plusy

- Elastyczność w wykorzystaniu LLM

- Dokumentocentryczny

- Platforma posiada agentów AI do automatyzacji zadań

Wady

- Brakuje obsługi wielu użytkowników

- Złożoność zaawansowanych funkcji

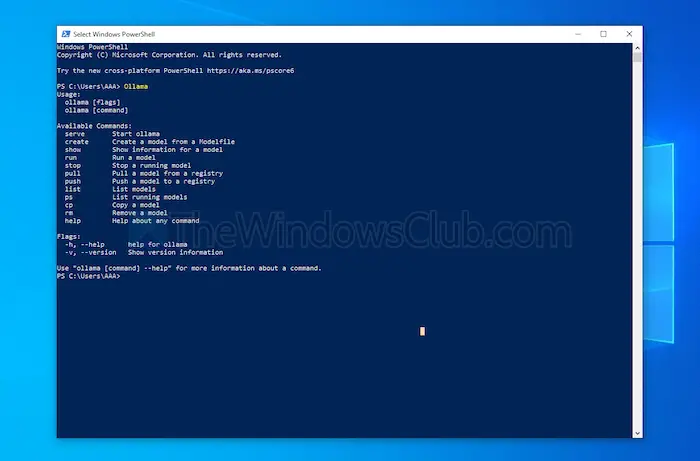

5] Być

Ollama daje pełną kontrolę nad tworzeniem lokalnych chatbotów bez API. Obecnie ma najważniejszych współpracowników, którzy zapewniają częste aktualizacje i poprawiają ogólną funkcjonalność GitHub. To aktualizuje to narzędzie i zapewnia lepszą wydajność niż inne. W przeciwieństwie do innych narzędzi omówionych powyżej, otwiera interfejs terminala w celu zainstalowania i uruchomienia modelu.

Każdy instalowany model ma własną konfigurację i wagę, co pozwala uniknąć konfliktów z innym oprogramowaniem na komputerze. Oprócz interfejsu wiersza poleceń Ollama posiada interfejs API zgodny z OpenAI. Możesz łatwo zintegrować to narzędzie z narzędziem korzystającym z modeli OpenAI.

Cechy

- Wdrożenie lokalne:Ollama umożliwia uruchamianie dużych modeli językowych w trybie offline, takich jak Llama, Mistral i inne.

- Dostosowywanie modelu:Zaawansowani użytkownicy mogą ustawić zachowanie w modelach za pomocą pliku Modefile.

- Zgodność API OpenAI:Posiada API REST kompatybilne z API OpenAI.

- Zarządzanie zasobami:Optymalizuje wykorzystanie procesora i karty graficznej, nie przeciążając systemu.

Plusy

- Możesz zdobyć kolekcję modeli.

- Może importować modele z bibliotek typu open source, takich jak PyTorch.

- Ollama może integrować się z ogromnym wsparciem bibliotecznym

Wady

- Nie zapewnia graficznego interfejsu użytkownika

- Wymaga dużych wymagań dotyczących przechowywania

Wniosek

Podsumowując, lokalne narzędzia LLM stanowią godną alternatywę dla modeli opartych na chmurze. Oferują wyższy poziom prywatności i kontroli bez żadnych kosztów. Niezależnie od tego, czy zależy Ci na łatwości obsługi, czy na dostosowaniu, wymienione narzędzia oferują różnorodne potrzeby i poziomy wiedzy.

W zależności od Twoich potrzeb, takich jak moc obliczeniowa i kompatybilność, każdy z nich może wykorzystać potencjał sztucznej inteligencji bez narażania prywatności i konieczności opłat abonamentowych.

![Aby przerwać normalny uruchomienie, naciśnij Enter Error na laptopie Lenovo [naprawy]](https://elsefix.com/tech/tejana/wp-content/uploads/2025/02/To-interrupt-normal-startup-press-Enter.png)