Você deseja que seus dados permaneçam privados e nunca saiam do seu dispositivo? Os serviços Cloud LLM geralmente vêm com taxas de assinatura contínuas com base em chamadas de API. Mesmo os usuários em áreas remotas ou com conexões de Internet não confiáveis não preferem especificamente os serviços em nuvem. Então, qual é a solução?

Felizmente, as ferramentas locais de LLM podem eliminar esses custos e permitir que os usuários executem modelos em seu hardware. As ferramentas também processam dados offline para que nenhum servidor externo possa acessar suas informações. Você também terá mais controle sobre a interface específica do seu fluxo de trabalho.

Neste guia, reunimos osFerramentas LLM locais gratuitaspara cumprir todas as suas condições e, ao mesmo tempo, atender às suas necessidades de privacidade, custo e desempenho.

Aqui estão algumas ferramentas locais gratuitas de LLM que foram escolhidas a dedo e testadas pessoalmente.

- janeiro

- Estúdio LM

- GPT4ALL

- Qualquer coisa LLM

- Ser

1] janeiro

Você conhece ChatGPT? Nesse caso, Jan é uma versão que funciona offline. Você pode executá-lo em seu dispositivo pessoal sem internet. Ele permite gerar, analisar e processar dados de texto de forma privada em sua rede local.

Ele vem com modelos de primeira linha como Mistral, Nvidia ou OpenAI que você pode usar sem enviar dados para outro servidor. Esta ferramenta é adequada se você priorizae deseja uma alternativa robusta aos LLMs baseados em nuvem.

Características

- Modelos pré-construídos:Ele fornece modelos de IA instalados que estão prontos para uso sem procedimentos adicionais.

- Personalização:Altere a cor do painel e torne o tema sólido ou translúcido.

- Verificação ortográfica:Use esta opção para corrigir erros ortográficos.

Prós

- Importe seus modelos usando a fonte Hugging Face.

- Suporta extensões para personalização.

- Gratuito

Contras

- Menos suporte da comunidade Jan carece de suporte da comunidade e os usuários podem encontrar menos tutoriais e recursos.

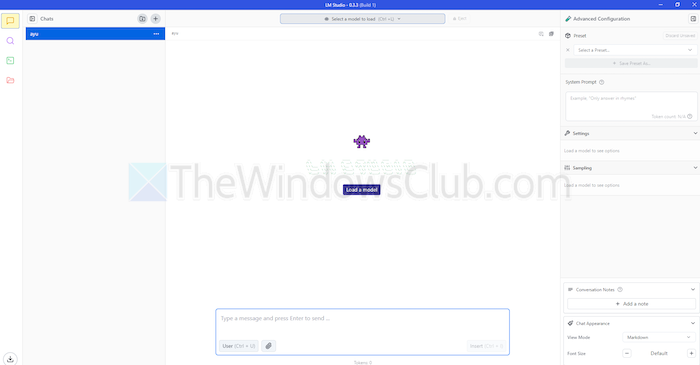

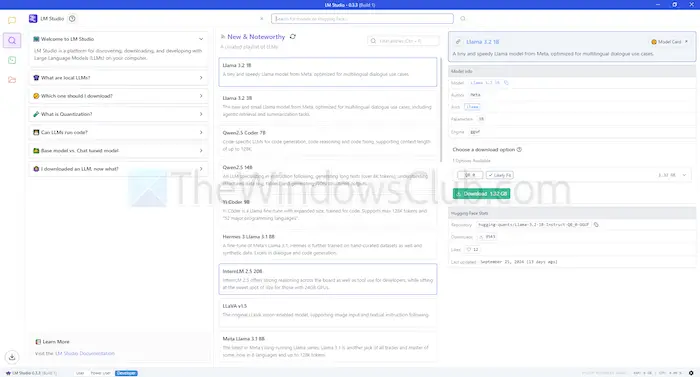

2] Estúdio LM

LM Studio é outra ferramenta para usar modelos de linguagem, como ChatGPT localmente. Oferece modelos grandes e aprimorados para compreender e responder às suas solicitações. Mas, ao contrário dos modelos baseados em nuvem, você permanece no seu dispositivo. Ou seja, há mais privacidade e controle sobre seu uso.

O LM Studio pode resumir textos, gerar conteúdo, responder às dúvidas desejadas ou até auxiliar na codificação, tudo na sua máquina. Antes de executar um modelo, você pode obter um relatório sobre se o seu sistema pode lidar com ele. Isso permite que você gaste seu tempo e recursos apenas em modelos compatíveis.

Características

- Anexos de arquivos e RAG:Você pode fazer upload de arquivos PDF, docx, txt e CSV na caixa de bate-papo e obter as respostas adequadas.

- Faixa de personalização:Oferece vários temas de cores e permite escolher o nível de complexidade da interface.

- Denso de recursos:Oferece documentação gratuita e maneiras de aprender e usar a ferramenta.

Prós

- Você pode usá-lo em Linux, Mac ou Windows.

- Configuração de servidor local para desenvolvedores.

- Oferece uma lista de reprodução com curadoria de modelos

Contras

- Pode ser complexo começar a trabalhar, especialmente para os recém-chegados.

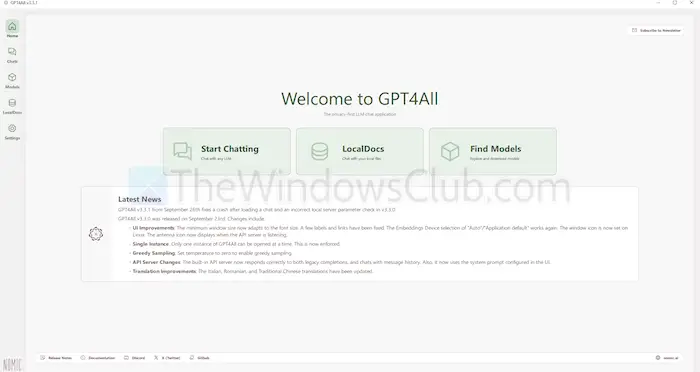

3]GPT4ALL

GPT4ALL é outra ferramenta LLM que pode executar modelos em seus dispositivos sem conexão com a internet ou mesmo integração de API. Este programa funciona sem GPUs, embora possa aproveitá-las, se disponíveis, o que o torna adequado para muitos usuários. Ele também oferece suporte a uma variedade de arquiteturas LLM, o que o torna compatível com modelos e estruturas de código aberto.

Ele também usa llama.cpp como back-end para LLMs, o que melhora o desempenho do modelo em CPUs e GPUs sem infraestrutura de ponta. GPT4ALL é compatível com processadores Intel e AMD; ele usa GPUs para processamento mais rápido.

Características

- Interação de arquivos locais:Os modelos podem consultar e interagir com arquivos locais. Como PDFs ou documentos de texto, usando Documentos Locais.

- Eficiente:Muitos modelos estão disponíveis em versões de 4 bits, que utilizam menos memória e processamento.

- Extensa biblioteca de modelos:GPT4ALL possui mais de 1.000 modelos de código aberto de repositórios como Hugging Face.

Prós

- Código aberto e transparente

- Ele oferece um pacote específico para empresas usarem IA localmente.

- GPT4ALL foca fortemente na privacidade

Contras

- Suporte limitado para processadores ARM, como Chromebooks

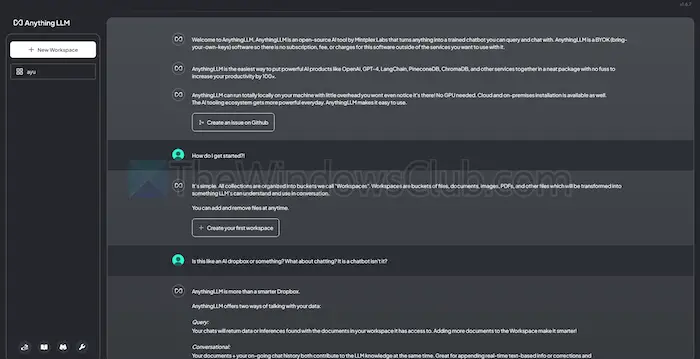

4] Qualquer coisaLLM

AnythingLLM é um LLM de código aberto que oferece alta personalização e uma experiência privada de IA. Ele permite que os usuários implantem e executem LLMs off-line em seus dispositivos locais, como Mac, Windows ou Linux, garantindo total

Além disso, a ferramenta é mais adequada para usuários individuais que desejam uma solução fácil de instalar com configuração mínima. Você pode tratá-lo como um sistema privado do tipo CharGPT que empresas ou indivíduos podem administrar.

Características

- Amigável ao desenvolvedor:Possui uma API completa para integração customizada.

- Integração de ferramentas:Você pode integrar ferramentas adicionais e gerar chaves de API.

- Configuração fácil:Possui um processo de instalação com um único clique.

Prós

- Flexibilidade no uso do LLM

- Centrado em Documentos

- A plataforma conta com agentes de IA para automatizar tarefas

Contras

- Falta suporte multiusuário

- Complexidade em recursos avançados

5] Ser

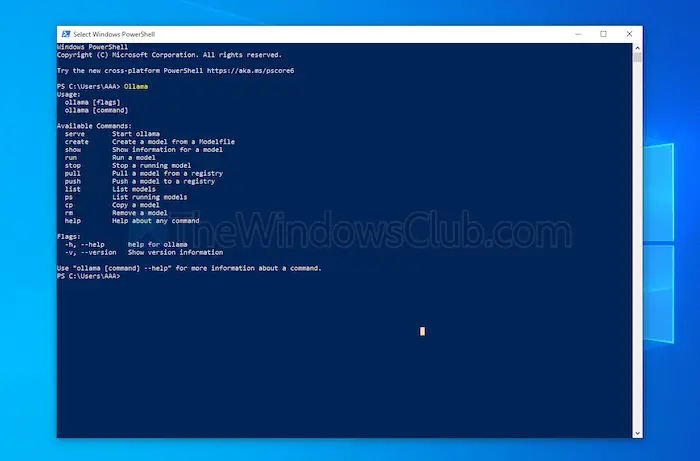

Ollama oferece controle total na criação de chatbots locais sem API. Atualmente, conta com os contribuidores mais significativos que fornecem atualizações frequentes e melhoram a funcionalidade geral do GitHub. Isso atualiza esta ferramenta e fornece melhor desempenho do que outras. Ao contrário das outras ferramentas discutidas acima, ela abre uma interface de terminal para instalar e iniciar um modelo.

Cada modelo que você instala tem configurações e pesos próprios, evitando conflitos com outros softwares da sua máquina. Junto com sua interface de linha de comando, Ollama possui uma API compatível com OpenAI. Você pode integrar facilmente esta ferramenta com outra que use modelos OpenAI.

Características

- Implantação local:Ollama permite executar grandes modelos de linguagem offline, como Llama, Mistral ou outros.

- Personalização do modelo:Usuários avançados podem definir o comportamento em modelos usando um Modefile.

- Compatibilidade da API OpenAI:Possui uma API REST compatível com a API da OpenAI.

- Gerenciamento de recursos:Otimiza o uso de CPU e GPU, não sobrecarregando o sistema.

Prós

- Você pode obter uma coleção de modelos.

- Ele pode importar modelos de bibliotecas de código aberto, como PyTorch.

- Ollama pode ser integrado com um tremendo suporte de biblioteca

Contras

- Não fornece uma interface gráfica de usuário

- Requer grandes requisitos de armazenamento

Conclusão

Em resumo, as ferramentas locais de LLM oferecem uma alternativa válida aos modelos baseados em nuvem. Eles oferecem privacidade e controle de próximo nível sem nenhum custo. Quer você busque facilidade de uso ou personalização, as ferramentas listadas oferecem uma variedade de necessidades e níveis de conhecimento.

Dependendo das suas necessidades, como poder de processamento e compatibilidade, qualquer um deles pode aproveitar o potencial da IA sem comprometer a privacidade ou exigir taxas de assinatura.

![Carregador de laptop fazendo barulho [Correção]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/12/Laptop-charger-making-buzzing-noise.png)

![Nenhum driver gráfico AMD está instalado, erro no Windows 11 [Fix]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/09/No-AMD-graphics-driver-is-installed.png)