Om du inte vill betala för en LLM eller vill hålla dina data säkra, kan dubör ställa in LocalGPT. Det låter dig ha full kontroll över hur AI:n fungerar och bearbetar data. Det säkerställer också integritet eftersom all data stannar på ditt lokala system istället för att skickas till externa servrar.

Ställ in Local GPT på Windows PC

LocalGPT är ett verktyg med öppen källkod inspirerat avprivatGPT, designad för att köra stora språkmodeller (LLM) lokalt på användarenheter för privat bruk. Till skillnad från privateGPT, som enbart förlitar sig på CPU-utförande, stöder LocalGPT hårdvaruacceleration via GPU:er för bättre prestanda och minskad latens. Istället för GPT-4ALL-modellen och LlamaEmbeddings, som är ganska rejäla, använder LocalGPT Vicuna-7B LLM och InstructorEmbeddings. Det fungerar med modeller som Blenderbot och WizardLM-7B så att vi kan byta modeller baserat på specifika behov. Hela pipelinen fungerar lokalt, vilket säkerställer datasekretess samtidigt som den levererar avancerade NLP-funktioner utan extern API-beroende, vilket gör den till en perfekt kandidat för ett lokalt styrt AI-läge.

I den här guiden kommer vi att ställa in Local GPT på Windows. Du kan följa stegen som nämns nedan.

- Ladda ner och installera Miniconda

- Installera LocalGPT Repository

- Installera beroenden

- Kör LocalGPT

Låt oss diskutera dem i detalj.

1] Ladda ner och installera Miniconda

![]()

Miniconda är en lätt distribution av Conda-pakethanteraren, designad för att snabbt ställa in Python-miljöer. Det ger bara det väsentliga, vilket gör att användare kan anpassa sina installationer genom att lägga till specifika paket efter behov. För att ladda ner den, gå till anaconda.com, scrolla ner, gå tillMiniconda installatörer,och ladda ner den för Windows eftersom den här guiden är för Windows.

![]()

Kör nu installationsprogrammet och följ instruktionerna på skärmen för att slutföra installationsprocessen, men se till att när du är påAvancerade installationsalternativ,kryssa i alla rutorna och slutför till sist installationen.

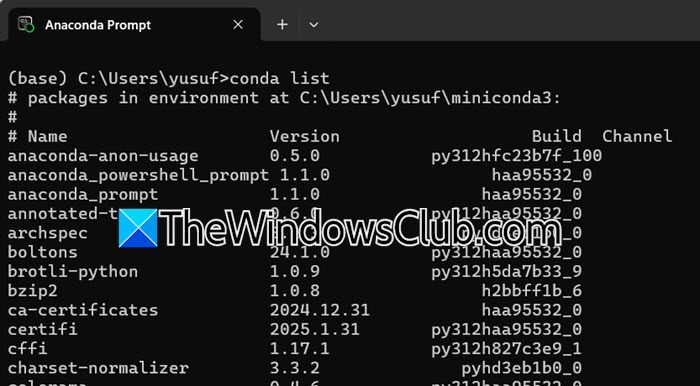

För att kontrollera om det är installerat eller inte, sök“Anaconda Prompt”i Start-menyn och öppna CLI. Nu kan du köraconda listabara för att bekräfta att den är installerad.

2] Installera LocalGPT Repository

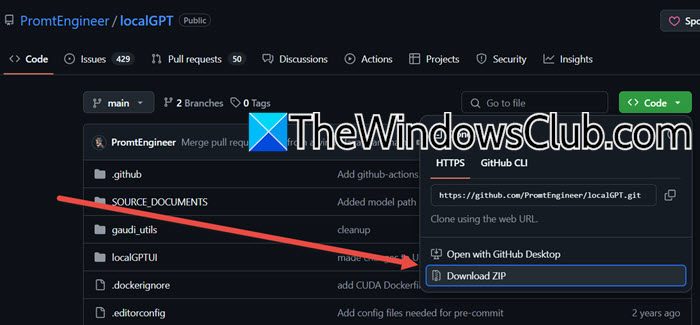

Nu måste vi installera LocalGPT Repository som är värd på GitHub av promptingenjören. Vi kan få det därifrån. För att göra det, navigera tillgithub.com. Du kan gå igenom sidan för att lära dig mer om LocalGPT och för att installera den måste du klicka påKod > Ladda ner ZIP.När ZIP-filen har laddats ner, gå tillLadda nerhögerklicka på ZIP-filen, välj Extrahera, ange en plats där du vill extrahera filen och slutför processen. Öppna den extraherade mappen, inuti den får du en mapp som heterLocalGPT-main.Bara för enkelhetens skull klistrar vi in mappen på skrivbordet och namnger den"LGPT".

3] Installationsberoenden

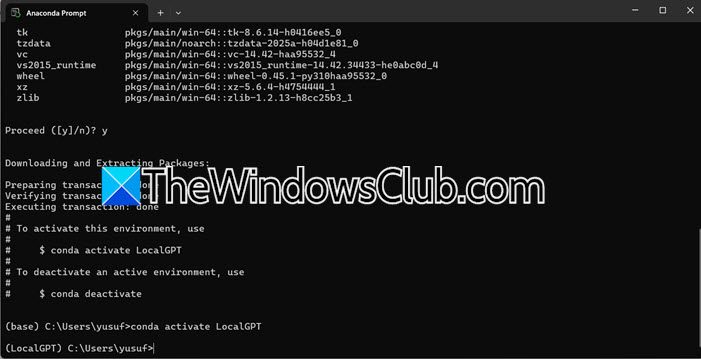

Nu måste vi skapa en virtuell miljö där vi ska installera alla beroenden. För att göra det, öppna“Anaconda Prompt”från Start-menyn och kör följande kommandon.

conda create -n environment_name python=3.10

conda activate environment_name

Obs: Byt ut variabeln "environment_name" med valfritt namn.

Om den ber dig att ladda ner något paket, vänligen ge ditt samtycke och fortsätt.

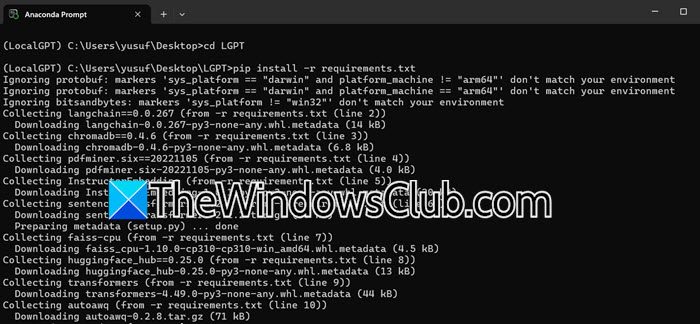

Nu måste vi installera paketet som vi laddade ner det extraherade tidigare. För att göra det måste du först navigera till katalogen med följande kommandon.

cd Desktop

cd LGPT

Istället för att installera alla komponenter en efter en kan vi använda följande kommando för att installera alla på en gång.

pip install -r requirements.txt

Du kan stöta på två fel.

- import fackla ModuleNotFoundError:Sikt

pip installera ficklampa torchvision torchaudiooch kör sedan det ovannämnda kommandot.

- Microsoft C++ krävs:Klicka på nämnda URL och ladda ner Visual Studio genom att klicka påLadda ner byggverktyg,när Visual Studio är öppet måste du gå igenom de verktyg du inte har och ladda ner dem.

När du har löst problemet kör du installationskommandot igen och när du har installerat det går du vidare till nästa steg.

4] Kör LocalGPT

Först och främst måste du köra Python Ingestion vilket innebär att importera data från källdokumenten, bearbeta dina dokument och lagra deras inbäddningar i en vektordatabas (Chroma DB). För att göra det måste du utföra följande kommando.

python ingest.py

Vi rekommenderar att du håller ett öga på CPU-användning med Task Manager.

Nu, aÖppna filen constants.py i din LocalGPT-katalog. Inaktivera Llama 3-modellen genom att lägga till en kommentar till dess linje, och aktivera Llama 2-modellen (7B-parametrar) genom att ta bort kommentaren från dess linje.

När du är klar måste du köra LocalGPT med följande kommando.

python run_local_gpt.py

Om du stöter på ett fel som anger detlamasaknas, springpip installera llama-cpp-python.

Förhoppningsvis kommer du att kunna köra LocalGPT på din dator lokalt med hjälp av denna guide.

Läsa:

Hur installerar man PrivateGPT på Windows?

För att installera PrivateGPT på Windows, installera först Python och en pakethanterare som Conda. Klona sedan PrivateGPT-förvaret och ställ in en virtuell miljö. Du måste sedan installera beroenden med Poetry eller PIP. Ladda ner en kompatibel språkmodell. Slutligen måste du konfigurera miljövariabler, mata in dokument och köra programmet för att börja söka efter dina data lokalt.

Läsa:

Hur ställer jag in WSL på Windows?

Till, öppna PowerShell som administratör och körwsl –installera. Detta aktiverar WSL, installerar Linux-kärnan och ställer in WSL 2 som standard. Starta om din dator och välj sedan en Linux-distribution att installera. Starta distributionen, skapa ett användarnamn och lösenord och du är redo att använda Linux på Windows.

Läs också:.