Con tantos avances en inteligencia artificial, rastrear las novedades y cómo pueden beneficiarle puede resultar abrumador. Uno de los últimos desarrollos que está causando sensación es GPT-4o. Pero, ¿qué es exactamente GPT-4o y cómo puede ayudarle a usted y a su equipo?

En este artículo, exploraremos lo siguiente:

- ¿Qué es GPT-4o?

- Cómo probar GPT-4o

- ¿GPT-4o es gratuito?

- ¿Qué son los puntos de referencia GPT-4o?

- ¿Cómo puedo hablar con GPT-4o?

- GPT-4o frente a GPT-4 y GPT-3.5

GPT-4o (omni) representa un salto significativo hacia interacciones más naturales entre humanos y computadoras. Este modelo puede aceptar y generar entradas y salidas en formatos de texto, audio, imagen y video. Con tiempos de respuesta de hasta 232 milisegundos, GPT-4o iguala los rápidos reflejos de la conversación humana.

GPT-4o destaca por su rendimiento mejorado en tareas multilingües, de audio y de visión. Coincide con GPT-4 Turbo en tareas de texto y codificación, con mejoras significativas en idiomas distintos del inglés. Sorprendentemente, es más rápido y un 50% más barato en la API. GPT-4o ofrece comprensión y generación superiores en visión y audio en comparación con modelos anteriores.

Capacidades del modelo

GPT-4o puede realizar diversas tareas, desde cantar y traducir en tiempo real hasta preparar entrevistas y comprender el sarcasmo. Ya sea jugando piedra, papel o tijera, narrando historias visuales o incluso contando chistes de papá, GPT-4o muestra varias habilidades interactivas. Su papel como modelo de texto y visión permite interacciones más dinámicas.

Anteriormente, las interacciones de voz con modelos como GPT-3.5 y GPT-4 implicaban múltiples pasos, lo que provocaba retrasos y limitaba la capacidad del modelo para procesar eficazmente el tono o varios hablantes. Ahora, GPT-4o integra todas estas modalidades en un modelo único y cohesivo, mejorando su capacidad de respuesta y expresividad emocional.

Las primeras demostraciones muestran al GPT-4o armonizando canciones, traduciendo idiomas sobre la marcha e incluso brindando servicio al cliente. Abre nuevas posibilidades para que la inteligencia artificial ayude en las tareas cotidianas, haga que el aprendizaje sea más interactivo y mejore la comunicación en diferentes idiomas y medios.

Cómo probar GPT-4o

A continuación se explica cómo utilizar GPT-4o de forma gratuita en su dispositivo Android o iOS:

- Instale la aplicación desde eloTienda de aplicaciones de Apple.

- Inicie sesión con los datos de su cuenta.

- Toque el icono en la esquina superior derecha y elija "GPT-4o".

Cómo probar GPT-4o

Cómo probar GPT-4o- Inicie su conversación con el modelo Omni más nuevo de OpenAI. Tenga en cuenta que la versión de Android actualmente no admite interrupciones en el chat del modo de voz.

¿GPT-4o es gratuito?

¡Sí! Los usuarios gratuitos pueden acceder a sus funciones avanzadas sin ningún costo.

Si bien la versión gratuita ofrece muchas funcionalidades, la suscripción Plus brinda beneficios adicionales. Además, los usuarios disfrutan de límites de mensajes más altos y acceso a funciones premium.

¿Qué son los puntos de referencia de GPT-4o?

GPT-4o demuestra un rendimiento superior en múltiples pruebas comparativas, destacando sus puntos fuertes en tareas de texto, audio y visión.

Evaluación de texto

GPT-4o – Evaluación de texto

GPT-4o – Evaluación de textoImagen de OpenAI

GPT-4o logra niveles de rendimiento a la par con GPT-4 Turbo en tareas de texto y codificación, estableciendo una nueva puntuación alta del 88,7 % en evaluaciones MMLU (comprensión masiva del lenguaje multitarea) de cadena de pensamiento (CoT) de disparo cero. Además, obtiene una puntuación del 87,2 % en la MMLU tradicional de cinco disparos sin CoT, lo que indica su excepcional capacidad de razonamiento y conocimiento general.

Estos puntajes significan que es excelente en el manejo de tareas complejas basadas en texto, al igual que su predecesor, el GPT-4 Turbo.

Más información:Cómo crear resúmenes de reuniones con OpenAI GPT-3

Rendimiento de audio

Rendimiento de audio GPT-4o

Rendimiento de audio GPT-4oImagen de OpenAI

En cuanto a las tareas de audio, GPT-4o destaca en reconocimiento automático de voz (ASR) y traducción de audio. Mejora significativamente el reconocimiento de voz con respecto a Whisper-v3 en varios idiomas, especialmente aquellos con menos recursos. GPT-4o también establece un nuevo estado del arte en traducción de voz, superando a Whisper-v3 en el punto de referencia MLS (Multilingual Speech).

Estos avances significan que GPT-4o es excelente para reconocer y traducir el habla. Es mucho mejor para comprender las palabras habladas que los modelos anteriores, especialmente en idiomas menos hablados. También puede traducir con precisión el lenguaje hablado a diferentes idiomas.

Comprensión de la visión

Comprensión de la visión GPT-4o

Comprensión de la visión GPT-4oImagen de OpenAI

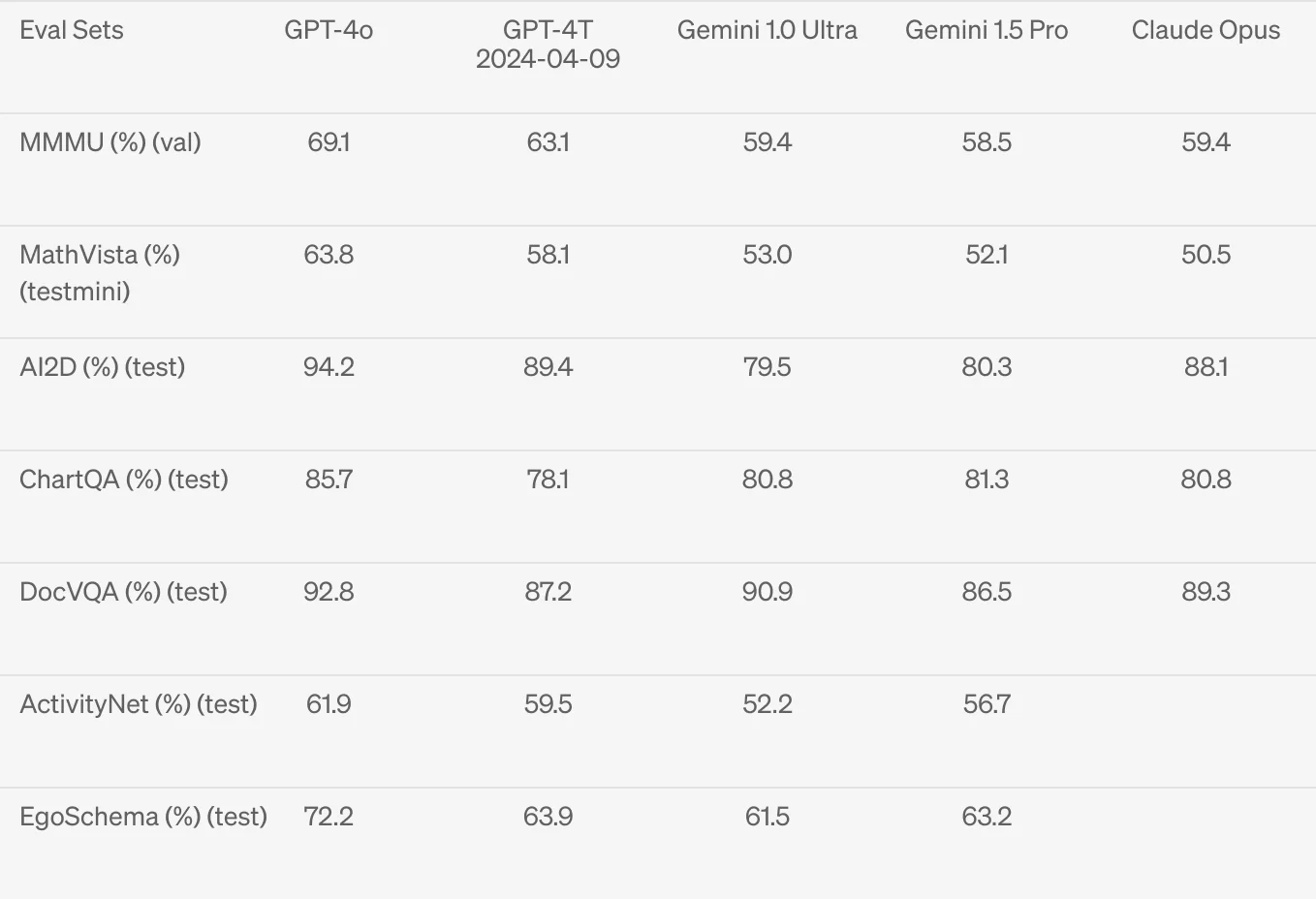

En tareas de visión, GPT-4o logra resultados de última generación en puntos de referencia de percepción visual. Destaca en evaluaciones de disparo cero, incluida la comprensión de máquinas multitarea multimodal (MMMU), MathVista y ChartQA. Estos puntos de referencia demuestran la capacidad de GPT-4o para comprender e interpretar entradas de imágenes complejas de manera efectiva.

Estos resultados significan que puede comprender e interpretar bien imágenes y datos visuales. Se probó en diversas tareas que requerían la comprensión de imágenes y gráficos y se desempeñó al más alto nivel.

Capacidades multilingües

GPT-4o también brilla en tareas multilingües, con un rendimiento mejorado en varios idiomas gracias a un nuevo tokenizador que comprime los tokens de idioma de manera más eficiente. Esto da como resultado que se requieran menos tokens para un procesamiento lingüístico preciso, lo que mejora sus capacidades en idiomas como gujarati, telugu, tamil, marathi, hindi, urdu, árabe, persa, ruso, coreano, vietnamita, chino, japonés, turco, italiano, alemán, español, portugués y francés.

¿Cómo puedo hablar con GPT-4o?

A continuación se explica cómo utilizar GPT-4o en su teléfono inteligente o computadora de escritorio:

Teléfono inteligente:

- Descargue la aplicación ChatGPT de Google Play o Apple Store en su teléfono inteligente.

- Abra la aplicación e inicie sesión con las credenciales de su cuenta. Si no tiene una cuenta, puede crear una fácilmente.

- Toque el menú a continuación y elija "GPT-4o".

Cómo hablar con GPT-4o

Cómo hablar con GPT-4o- Comience a interactuar con GPT-4o. Escriba sus preguntas o use el modo de voz para hablar directamente con el modelo. Para obtener más información sobre cómo funciona esto, consulte nuestro artículo sobre las capacidades de conversión de voz a texto de ChatGPT.

De oficina:

- Visite el sitio web de ChatGPT en su navegador de escritorio.

- Inicie sesión usando su cuenta.

- Haga clic en el menú de configuración, luego seleccione "GPT-4o".

GPT-4o en escritorio

GPT-4o en escritorio- Comience su conversación con GPT-4o escribiendo sus preguntas o usando el micrófono para interacciones de voz. Aprender a utilizar GPT4-o en su escritorio puede mejorar su productividad.

A continuación, se muestran algunos casos de uso comunes para hablar con GPT-4o:

Traducción en tiempo real

GPT-4o puede traducir el lenguaje hablado al instante. Por ejemplo, una persona puede hablar inglés y GPT-4o lo traducirá al español en tiempo real.

Aprendizaje interactivo

Utilice GPT-4o para dar tutoría a los estudiantes en diversas materias. Por ejemplo, puede ayudar a los estudiantes a resolver problemas matemáticos guiándolos paso a paso sin darles directamente las respuestas. También puede adoptar diferentes tonos según el contexto, lo que lo hace adecuado para entornos de aprendizaje formales e informales.

Atención al cliente

GPT-4o puede encargarse de tareas de servicio al cliente, como realizar llamadas para resolver problemas. Por ejemplo, puede llamar a una empresa en su nombre para solicitar un dispositivo de reemplazo, reduciendo el tiempo que pasa en espera y tratando con representantes de servicio al cliente.

Colaboración creativa

GPT-4o puede ayudar en proyectos creativos. Puede cantar, armonizar o incluso representar escenarios. Por ejemplo, puede entablar una conversación divertida contigo.

Asistencia diaria

GPT-4o puede resumir reuniones, tomar notas y enviar correos electrónicos resumidos. Por ejemplo, durante una reunión, puede identificar a los oradores, resumir los puntos clave y enviar las actas a todos los participantes.

Entretenimiento

GPT-4o puede jugar juegos como piedra, papel y tijera, responder con sarcasmo o incluso actuar como interlocutor en un debate. Por ejemplo, puede entablar una discusión divertida y atractiva sobre perros y gatos, tomando partido y aportando argumentos bien pensados.

¿Cómo se compara GPT-4o con GPT-4 y GPT-3.5?

Se destacan varias diferencias y mejoras clave al comparar GPT-4o con sus predecesores, GPT-4 y GPT-3.5.

Capacidades multimodales

GPT-4o está diseñado para manejar múltiples entradas y salidas, incluidos texto, audio, imágenes y video. Esta capacidad lo hace más versátil que GPT-4 y GPT-3.5, que se centran principalmente en el procesamiento de texto y, hasta cierto punto, de imágenes. La capacidad del GPT-4o para integrar entradas de audio y video significa que puede comprender y responder de manera más natural y dinámica, similar a las interacciones humanas.

Tiempo de respuesta

Uno de los avances importantes del GPT-4o es su tiempo de respuesta. Puede responder a entradas de audio en tan solo 232 milisegundos, comparable a los tiempos de respuesta de una conversación humana. Por el contrario, GPT-3.5 y GPT-4 tienen tiempos de respuesta más largos, especialmente al procesar entradas de audio.

Costo y eficiencia

GPT-4o está diseñado para ser más rápido y rentable. Es un 50% más barato en API en comparación con GPT-4 Turbo, lo que lo hace más accesible para una gama más amplia de aplicaciones. Sus mejoras de eficiencia también significan que puede manejar tasas de solicitudes más altas, brindando una experiencia más fluida a los usuarios.

Para comprender mejor cómo los límites de tokens afectan el rendimiento y el costo, consulte esta guía completa sobre límites de tokens para ChatGPT-3.5 y ChatGPT-4.

Actuación en idiomas distintos del inglés

GPT-4o muestra una mejora significativa en la comprensión y generación de texto en idiomas distintos del inglés. Si bien GPT-4 y GPT-3.5 tienen sólidas capacidades en inglés, GPT-4o amplía su dominio en varios idiomas, lo que lo convierte en una mejor opción para aplicaciones globales.

Modelo Integrado de Voz, Texto y Visión

A diferencia de GPT-3.5 y GPT-4, que utilizan modelos separados para diferentes tareas, GPT-4o integra todas las modalidades en un solo modelo. Esta integración permite a GPT-4o mantener el contexto y proporcionar respuestas más coherentes en varios tipos de entrada. Por ejemplo, puede interpretar señales visuales mientras responde a comandos de voz, ofreciendo una comprensión más holística de la entrada.

Casos de uso y aplicaciones

GPT-4o introduce nuevos casos de uso que no eran posibles o prácticos con GPT-4 y GPT-3.5. Estos incluyen aprendizaje interactivo en tiempo real, atención al cliente avanzada y colaboración creativa que implica cantar o contar historias. Su capacidad para comprender y generar contenido de audio y visual abre nuevas posibilidades para aplicaciones innovadoras.

Comprensión emocional y contextual mejorada

GPT-4o tiene capacidades mejoradas para detectar y transmitir emociones a través de la voz, lo que hace que las interacciones sean más naturales y atractivas. Esta función es un paso adelante con respecto a GPT-4 y GPT-3.5, que se centran principalmente en interacciones basadas en texto con un contexto emocional limitado.

En resumen, GPT-4o representa un avance significativo con respecto a GPT-4 y GPT-3.5, ya que ofrece capacidades multimodales mejoradas, tiempos de respuesta más rápidos, rentabilidad y rendimiento mejorado en múltiples idiomas. Su modelo integrado de voz, texto y visión proporciona una experiencia de IA más cohesiva y versátil. Sus capacidades de imagen lo hacen particularmente poderoso para diversas tareas visuales.

{{rt_cta_ai-conveniencia}}

Abrace el futuro con GPT-4o

GPT-4o cambia las reglas del juego en el mundo de la IA. Este modelo avanzado combina capacidades de texto, audio, video e imagen, haciendo que las interacciones sean más naturales e intuitivas. No sólo es más rápido y rentable, sino que también destaca en idiomas.

Puede utilizar GPT-4o para mejorar la traducción en tiempo real, participar en un aprendizaje interactivo, mejorar la atención al cliente o explorar proyectos creativos. Además, los usuarios gratuitos pueden acceder a estas funciones, lo que hace que la IA de primer nivel sea accesible para todos.

![Cómo instalar un sistema de arranque dual de Windows 11/Mac en Mac [todo procesador]](https://elsefix.com/tech/afton/wp-content/uploads/cache/2025/04/how-to-install-a-dual-system-on-mac.webp.webp.webp)