OpenAI siempre ha presentado mejoras importantes en su revolucionario chatbot ChatGPT. Esta vez, se trata de la función de voz que se le ha otorgado al chatbot para permitir que los usuarios puedan dar indicaciones usando su voz. La próxima actualización de ChatGPT permitirá a los usuarios elegir una voz y dar indicaciones fácilmente a ChatGPT a través de ella.

OpenAI no escatima esfuerzos para garantizar que ChatGPT mantenga constantemente su posición superior en el mundo de la inteligencia artificial. Antes, los usuarios solo podían dar indicaciones al chatbot de IA mediante texto, pero ahora se pueden proporcionar indicaciones rápidas mediante voz e imágenes.

Como dice OpenAI, “ChatGPT ahora puede ver, escuchar y hablar”, el chatbot de IA podrá responder de manera efectiva a sus indicaciones enviadas a través de imágenes o notas de voz. Ya sea que envíe una imagen de un problema matemático en un círculo o quiera hablar sobre una hermosa vista que acaba de presenciar en su camino de regreso a casa a través de una conversación de voz, ¡puede hacerlo todo!

ChatGPT responderá instantáneamente a tus indicaciones haciéndote sentir como si estuvieras manteniendo una conversación telefónica real con un amigo. Esta es una excelente manera de interactuar con el chatbot.

La actualización ha comenzado a implementarse para los usuarios de todo el mundo. La publicación del blog oficial de OpenAI menciona: “En las próximas dos semanas, implementaremos voz e imágenes en ChatGPT para los usuarios de Plus y Enterprise. La voz estará disponible en iOS y Android (opción opcional en la configuración) y las imágenes estarán disponibles en todas las plataformas”.

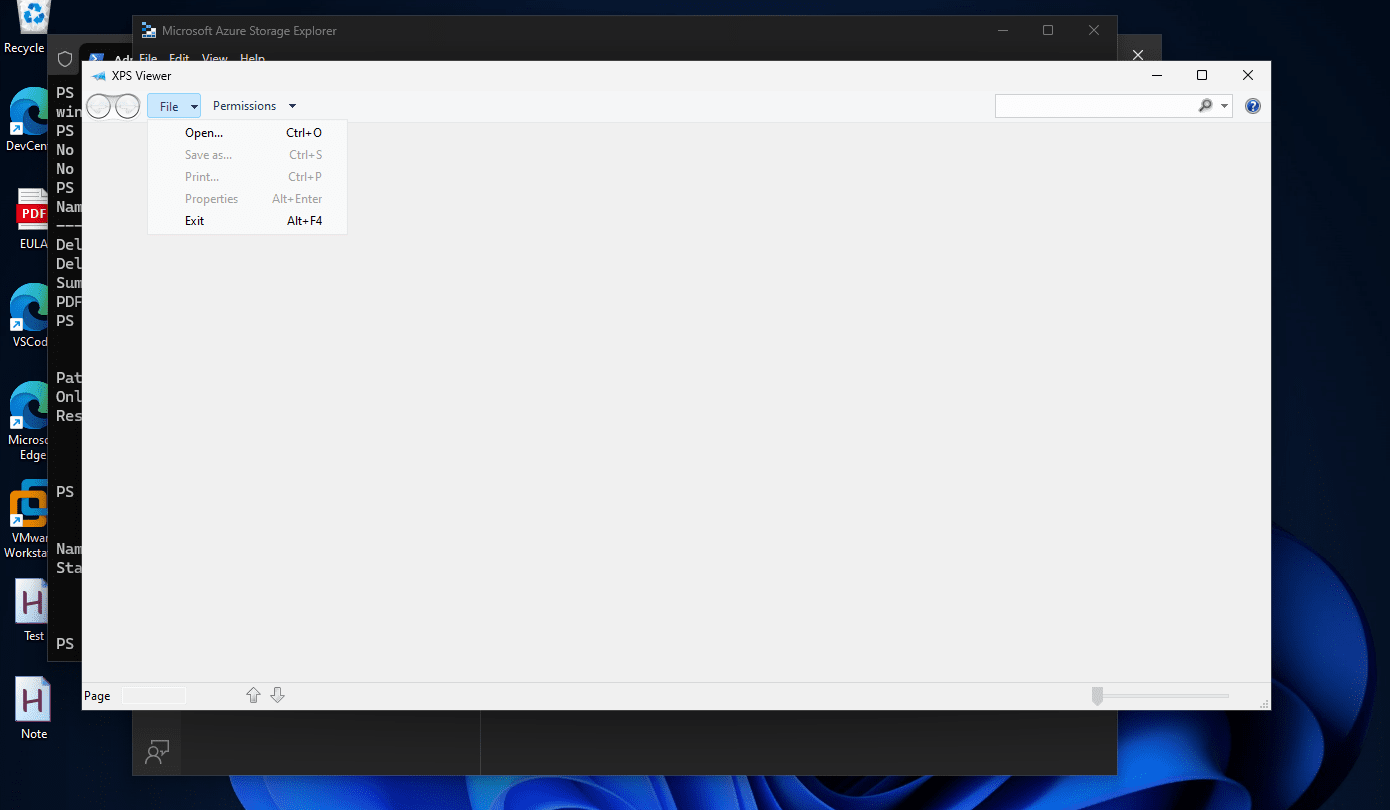

Para acceder a la nueva función de voz, deberá ir a la configuración de la aplicación y hacer clic en Nuevas funciones. Luego, busque el botón de auriculares en la esquina superior derecha. Habrá cinco opciones de voz y se le solicitará que elija la opción que prefiera.

OpenAI explicó que la función de voz funciona con un modelo de conversión de texto a voz. En la publicación del blog, mencionaron: “Colaboramos con actores de voz profesionales para crear cada una de las voces. También usamos Whisper, nuestro sistema de reconocimiento de voz de código abierto, para transcribir las palabras habladas en texto”.

Mientras tanto, la función de imagen está impulsada porModelos multimodales GPT-3.5 y GPT-4La comprensión de imágenes a través de las habilidades de razonamiento lingüístico de estos modelos permite al chatbot comprender una amplia gama de imágenes, incluidos documentos de texto, capturas de pantalla y fotografías de cámara.

Con la función de voz, ChatGPT se acerca un poco más a otros asistentes de voz de IA como Amazon Alexa, Siri de Apple y otros. Estas capacidades mejorarán la experiencia del usuario y permitirán que los usuarios utilicen ChatGPT con mayor frecuencia, más ampliamente y de manera más eficaz.