Vil du have, at dine data skal forblive private og aldrig forlade din enhed? Cloud LLM -tjenester leveres ofte med løbende abonnementsgebyrer baseret på API -opkald. Selv brugere i fjerntliggende områder eller dem med upålidelige internetforbindelser foretrækker ikke specifikt skytjenester. Så hvad er løsningen?

Heldigvis kan lokale LLM -værktøjer eliminere disse omkostninger og give brugerne mulighed for at køre modeller på deres hardware. Værktøjerne behandler også data offline, så ingen eksterne servere kan få adgang til dine oplysninger. Du får også mere kontrol over grænsefladen, der er specifik for din arbejdsgang.

I denne vejledning har vi samletGratis lokale LLM -værktøjerAt opfylde alle dine betingelser, mens du opfylder dit privatliv, omkostninger og præstationsbehov.

Gratis værktøjer til at køre LLM lokalt på Windows 11 PC

Her er nogle gratis lokale LLM -værktøjer, der er blevet håndplukket og personligt testet.

- Jan

- LM Studio

- Gpt4all

- Noget LLM

- Ollama

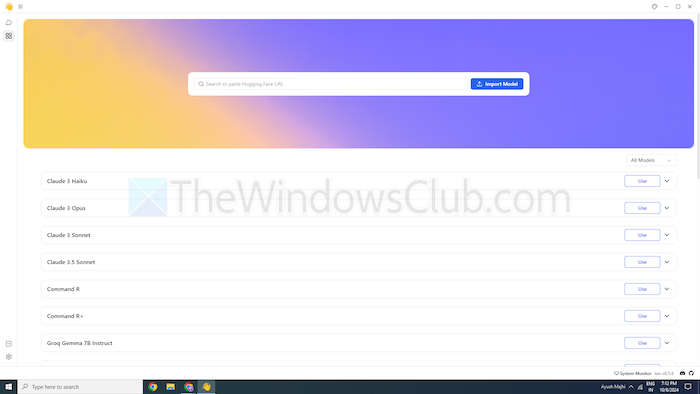

1] Jan

Er du bekendt med Chatgpt? I så fald er Jan en version, der fungerer offline. Du kan køre det på din personlige enhed uden internettet. Det giver dig mulighed for privat at generere, analysere og behandle tekstdata på dit lokale netværk.

Det leveres med top-notch-modeller som Mistral, Nvidia eller Openai, som du kan bruge uden at sende data til en anden server. Dette værktøj er egnet, hvis du prioritererog vil have et robust alternativ til skybaseret LLMS.

Funktioner

- Forudbyggede modeller:Det giver installerede AI -modeller, der er klar til brug uden yderligere procedurer.

- Tilpasning:Skift instrumentbrættets farve og gør temaet solidt eller gennemskinneligt.

- Stavekontrol:Brug denne mulighed til at løse stavefejlene.

Fordele

- Importer dine modeller ved hjælp af Hugging Face Source.

- Det understøtter udvidelser til tilpasning.

- Uden omkostninger

Ulemper

- Mindre samfundsstøtte Jan mangler samfundsstøtte, og brugere kan finde færre tutorials og ressourcer.

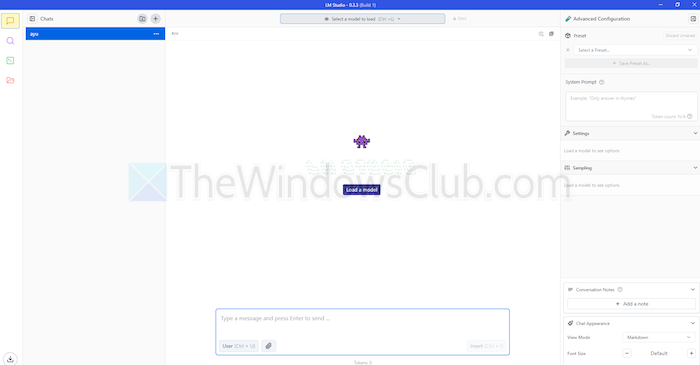

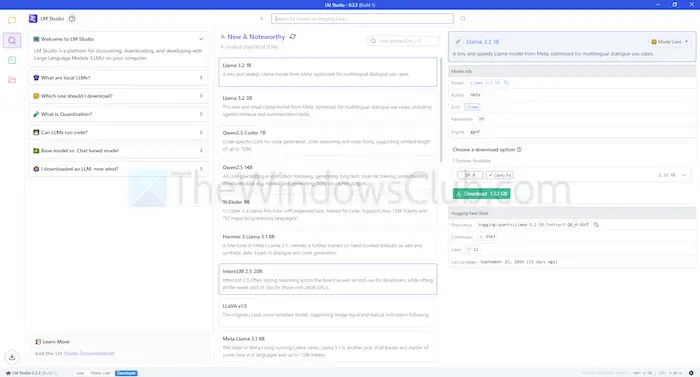

2] LM Studio

LM Studio er et andet værktøj til at bruge sprogmodeller, som ChatGpt lokalt. Det tilbyder store, forbedrede modeller til at forstå og svare på dine anmodninger. Men i modsætning til skybaserede modeller forbliver du på din enhed. Med andre ord er der mere privatliv og kontrol over brugen.

LM Studio kan opsummere tekster, generere indhold, besvare dine ønskede spørgsmål eller endda hjælpe med kodning, alt sammen fra din maskine. Før du kører en model, kan du få en rapport om, hvorvidt dit system kan håndtere den. Dette giver dig mulighed for kun at bruge din tid og ressourcer på kompatible modeller.

Funktioner

- Filmuligheder og klud:Du kan uploade PDF, DOCX, TXT og CSV -filer under chatboksen og få svar i overensstemmelse hermed.

- Område til tilpasning:Det tilbyder flere farvetemaer og giver dig mulighed for at vælge kompleksitetsniveauet for grænsefladen.

- Ressource tæt:Det tilbyder gratis dokumentation og måder at lære og bruge værktøjet på.

Fordele

- Du kan bruge det på Linux, Mac eller Windows.

- Lokal serveropsætning til udviklere.

- Det tilbyder en kurateret playliste med modeller

Ulemper

- Det kan være komplekst at begynde at arbejde, specifikt for nykommere.

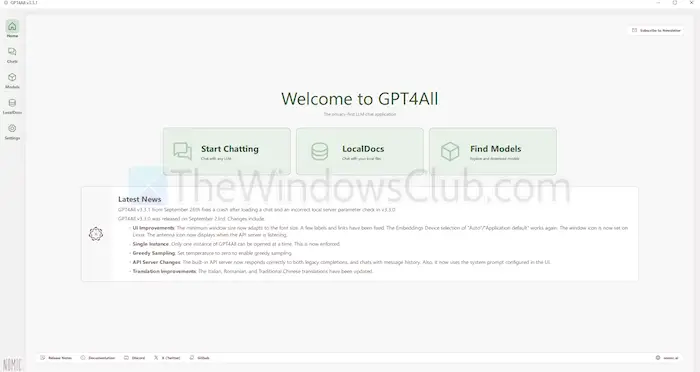

3] gpt4all

GPT4ALL er et andet LLM -værktøj, der kan køre modeller på dine enheder uden en internetforbindelse eller endda API -integration. Dette program kører uden GPU'er, skønt det kan udnytte dem, hvis det er tilgængeligt, hvilket gør det velegnet til mange brugere. Det understøtter også en række LLM-arkitekturer, hvilket gør det kompatibelt med open source-modeller og rammer.

Den bruger også LLAMA.CPP som sin backend for LLMS, hvilket forbedrer modelydelsen på CPU'er og GPU'er uden avanceret infrastruktur. GPT4ALL er kompatibel med både Intel- og AMD -processorer; Det bruger GPU'er til hurtigere behandling.

Funktioner

- Lokal filinteraktion:Modeller kan forespørge og interagere med lokale filer. Ligesom PDFS eller tekstdokumenter ved hjælp af lokale dokumenter.

- Effektiv:Mange modeller fås i 4-bit versioner, der bruger mindre hukommelse og behandling.

- Omfattende modelbibliotek:GPT4ALL har over 1000 open source-modeller fra opbevaringssteder som Hugging Face.

Fordele

- Open source og gennemsigtig

- Det tilbyder en bestemt pakke til virksomheder at bruge AI lokalt.

- Gpt4all fokuserer stærkt på privatlivets fred

Ulemper

- Begrænset support til armprocessorer såsom Chromebooks

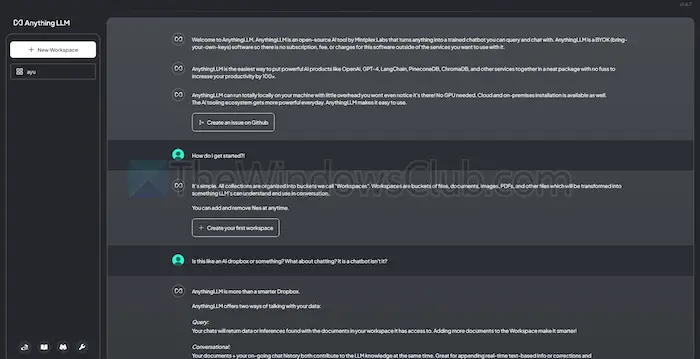

4] Anythlllm

Anythllm er en open source LLM, der tilbyder høj tilpasning og en privat AI-oplevelse. Det giver brugerne mulighed for at implementere og køre LLMS offline på deres lokale enheder, såsom Mac, Windows eller Linux, hvilket sikrer komplet

Desuden passer værktøjet bedst med en enkelt brugere, der ønsker en let at installere løsning med minimal opsætning. Du kan behandle det som et privat Chargpt-lignende system, som virksomheder eller enkeltpersoner kan køre.

Funktioner

- Udviklervenlig:Det har en komplet API til brugerdefineret integration.

- Værktøjsintegration:Du kan integrere yderligere værktøjer og generere API -nøgler.

- Nem opsætning:Det har en enkelt-klik-installationsproces.

Fordele

- Fleksibilitet i LLM -brug

- Dokumentcentrisk

- Platformen har AI -agenter til at automatisere opgaver

Ulemper

- Mangler support til multi-user

- Kompleksitet i avancerede funktioner

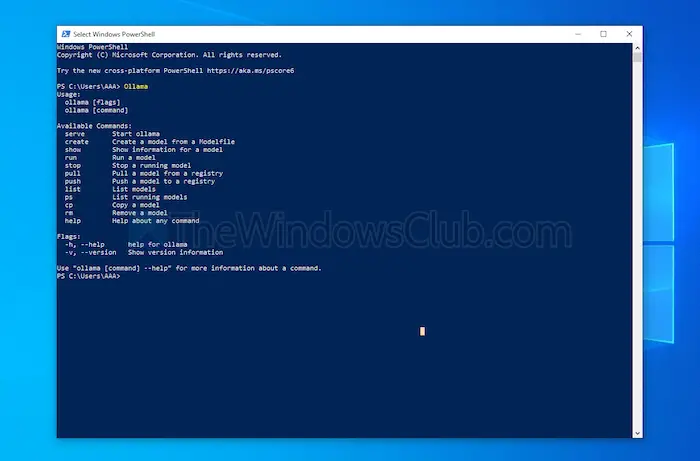

5] Ollama

Ollama giver fuld kontrol over at skabe lokale chatbots uden API. I øjeblikket har det de mest betydningsfulde bidragydere, der leverer hyppige opdateringer og forbedrer den overordnede funktionalitet af GitHub. Dette opdaterer dette værktøj og giver bedre ydelse end andre. I modsætning til de andre værktøjer, der er diskuteret ovenfor, åbner det en terminalgrænseflade for at installere og starte en model.

Hver model, du installerer, har sine egne konfigurationer og vægte, der undgår konflikter med anden software på din maskine. Sammen med sin kommandolinjegrænseflade har OlLama en API -kompatibel med Openai. Du kan nemt integrere dette værktøj med et, der bruger Openai -modeller.

Funktioner

- Lokal implementering:Ollama giver dig mulighed for at køre store sprogmodeller offline, såsom lama, mistral eller andre.

- Modeltilpasning:Avancerede brugere kan indstille adfærd i modeller ved hjælp af en modefil.

- Openai API -kompatibilitet:Det har en REST API -kompatibel med Openais API.

- Ressourcestyring:Det optimerer CPU- og GPU -brug og overbelaster ikke systemet.

Fordele

- Du kan få en samling af modeller.

- Det kan importere modeller fra open source-biblioteker som Pytorch.

- Ollama kan integreres med enormt bibliotekstøtte

Ulemper

- Det giver ikke en grafisk brugergrænseflade

- Kræver store opbevaringskrav

Konklusion

Sammenfattende tilbyder lokale LLM-værktøjer et værdigt alternativ til skybaserede modeller. De tilbyder privatliv og kontrol på næste niveau uden omkostninger. Uanset om du sigter mod brugervenlighed eller tilpasning, giver de anførte værktøjer forskellige behov og ekspertise niveauer.

Afhængig af dine behov, såsom behandlingskraft og kompatibilitet, kan nogen af disse udnytte AI's potentiale uden at gå på kompromis med privatlivets fred eller kræve abonnementsgebyrer.

![Opstartsapps vises ikke i appen Indstillinger i Windows 11 [Ret]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/12/startup-not-showing-settings-windows-11.png)