Das KI-Unternehmen Anthropic wird seine Leistung drastisch verbessernmit Plänen, sein Kontextfenster von 200.000 Token auf beeindruckende 500.000 Token zu erweitern.

Dieses riesige 500.000-Token-Fenster ermöglicht die direkte Verarbeitung umfangreicher Informationen und vermeidet gleichzeitig die Kontextverwirrung, die häufig mit der Retrieval-Enhanced-Generierung (RAG) einhergeht. Dank der erweiterten Funktionalität eignet sich Claude gut für die Bewältigung komplexer Aufgaben wie die Analyse politischer Dokumente, die Verwaltung extrem langer Codebasen mit Hunderttausenden Zeilen und die Erstellung umfassender dokumentübergreifender Zusammenfassungen. Branchenexperten weisen jedoch darauf hin, dass dieses umfangreiche Kontextfenster zu Herausforderungen im Zusammenhang mit der Speichernutzung und den Rechenkosten führen kann. Gleichzeitig muss die praktische Auslastung einer derart umfangreichen Modellkapazität noch gründlich bewertet werden.

Für diejenigen, die mit dem Konzept nicht vertraut sind: Ein Kontextfenster funktioniert ähnlich wie eine menschliche Aufmerksamkeitsspanne – es stellt den Bereich früherer Inhalte dar, die ein Kontextfenster aufweistkann beim Generieren jedes neuen Tokens referenziert werden. So wie Menschen sich nur auf begrenzte Informationen gleichzeitig konzentrieren können, sind KI-Modelle traditionell durch ihre Kontextfenster eingeschränkt.

Das Kontextfenster bestimmt, wie viele Informationen das Modell bei der Textgenerierung berücksichtigen kann. Diese Funktion hilft Claude, kohärente und relevante Antworten zu erstellen, ohne überladene oder irrelevante Ausgaben zu erzeugen, die durch Verweise auf übermäßigen Kontext entstehen könnten.

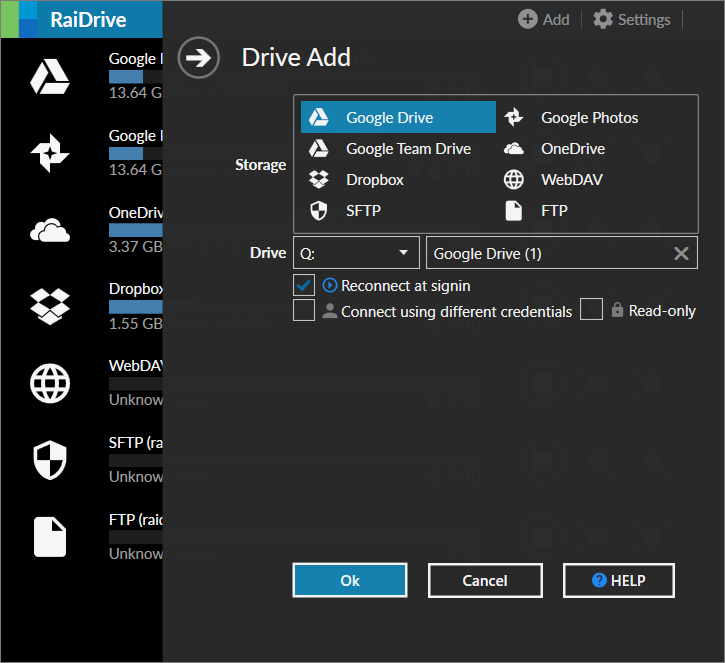

Laut Insider-Quellen, wird diese bahnbrechende Funktion wahrscheinlich zuerst für Unternehmenskunden eingeführt. Das Programmiertool Cursor hat bereits eine implementiert„Claude Sonnet 3.7 MAX“Option innerhalb seinerintegrierte Entwicklungsumgebung. Anthropic hat konsequent Lösungen der Enterprise-Klasse priorisiert, und dieses bedeutende Upgrade scheint die Long-Context-Funktionen, die von Wettbewerbern wie z. B. angeboten werden, direkt in Frage zu stellen

Diese rechtzeitige Verbesserung fällt mit der immer beliebter werdenden KI-gesteuerten „Vibe-Codierung“ zusammen, bei der Entwickler Code durch intuitive Beschreibungen in natürlicher Sprache generieren. Das erweiterte 500.000-Token-Fenster wird die kontinuierliche Entwicklung wesentlich größerer Projekte unterstützen, Störungen durch Token-Beschränkungen minimieren und die Eintrittsbarrieren in die Programmierung weiter reduzieren.