De nos jours, le développement de l’IA implique de temps en temps des comparaisons avec d’autres modèles. Récemment, il a été rapporté que Google pourrait utiliser le modèle Claude de son rival Anthropic pour améliorer la sécurité de son propre modèle.

TechCrunch rapporte que Google charge un sous-traitant de comparer la production de Gemini avec celle de Claude. Il faut jusqu'à 30 minutes au personnel externalisé pour évaluer chaque ensemble de réponses, et le rapport cite le personnel externalisé disant avoir trouvé plusieurs résultats dans le contenu en attente sur la plate-forme interne de Google avec la légende "Je m'appelle Claude d'Anthropic". .»

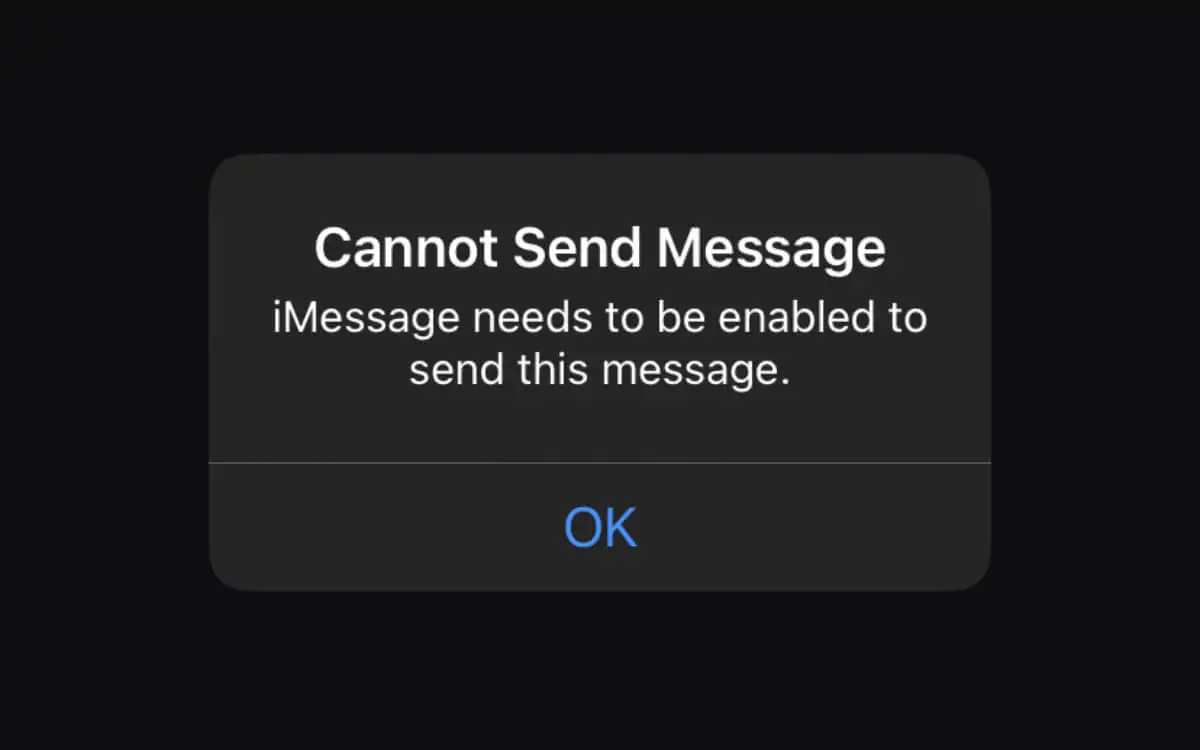

Selon l'employé externalisé, Claude a surpassé Gemini en termes de sécurité, et Claude refuserait de répondre à des invites dangereuses, telles que des jeux de rôle, et Gemini avait généré du contenu inapproprié à certaines invites. Bien que Google soit l'un des principaux investisseurs d'Anthropic, les conditions d'utilisation d'Anthropic interdisent explicitement l'utilisation sans licence de Claude pour développer des produits concurrents ou former des modèles d'IA concurrents.

La porte-parole de Google DeepMind, Shira McNamara, a admis qu'ils comparaient effectivement les résultats du modèle d'IA, mais a nié avoir utilisé Claude pour entraîner Gemini, mais n'a pas répondu s'ils avaient obtenu une licence d'Anthropic pour effectuer la comparaison des résultats.