Vil du at dataene dine skal forbli private og aldri forlate enheten din? Cloud LLM-tjenester kommer ofte med løpende abonnementsavgifter basert på API-anrop. Selv brukere i avsidesliggende områder eller de med upålitelige internettforbindelser foretrekker ikke spesifikt skytjenester. Så hva er løsningen?

Heldigvis kan lokale LLM-verktøy eliminere disse kostnadene og tillate brukere å kjøre modeller på maskinvaren. Verktøyene behandler også data offline slik at ingen eksterne servere kan få tilgang til informasjonen din. Du vil også få mer kontroll over grensesnittet som er spesifikt for arbeidsflyten din.

I denne guiden har vi samletgratis lokale LLM-verktøyfor å oppfylle alle betingelsene dine samtidig som du oppfyller dine personvern-, kostnads- og ytelsesbehov.

Her er noen gratis lokale LLM-verktøy som er håndplukket og personlig testet.

- Jan

- LM Studio

- GPT4ALL

- Hva som helst LLM

- Å være

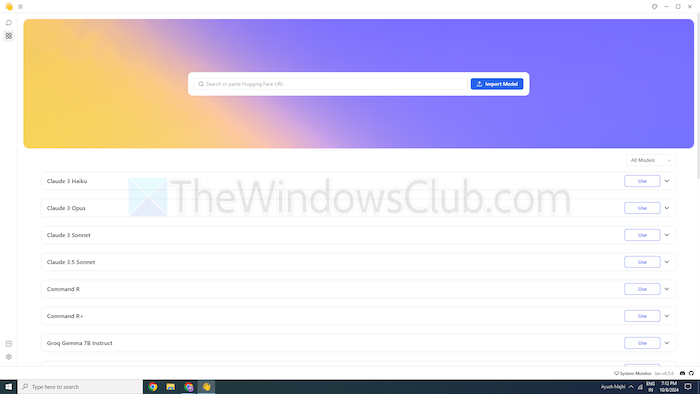

1] jan

Er du kjent med ChatGPT? I så fall er Jan en versjon som fungerer offline. Du kan kjøre den på din personlige enhet uten internett. Den lar deg generere, analysere og behandle tekstdata privat på ditt lokale nettverk.

Den kommer med toppmodeller som Mistral, Nvidia eller OpenAI som du kan bruke uten å sende data til en annen server. Dette verktøyet passer hvis du prioritererog ønsker et robust alternativ til skybaserte LLM-er.

Funksjoner

- Forhåndsbygde modeller:Den gir installerte AI-modeller som er klare til bruk uten ytterligere prosedyrer.

- Tilpasning:Endre fargen på dashbordet og gjør temaet solid eller gjennomskinnelig.

- Stavekontroll:Bruk dette alternativet til å fikse stavefeilene.

Fordeler

- Importer modellene dine ved hjelp av Hugging Face-kilden.

- Den støtter utvidelser for tilpasning.

- Gratis

Ulemper

- Mindre fellesskapsstøtte Jan mangler fellesskapsstøtte, og brukere kan finne færre veiledninger og ressurser.

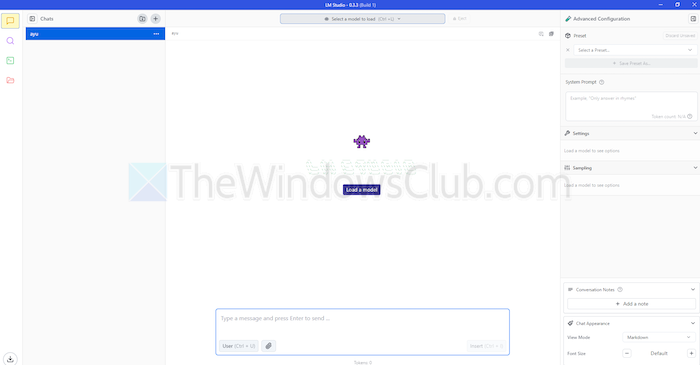

2] LM Studio

LM Studio er et annet verktøy for å bruke språkmodeller, som ChatGPT lokalt. Den tilbyr store, forbedrede modeller for å forstå og svare på dine forespørsler. Men i motsetning til skybaserte modeller, forblir du på enheten din. Med andre ord, det er mer privatliv og kontroll over bruken.

LM Studio kan oppsummere tekster, generere innhold, svare på ønskede spørsmål eller til og med hjelpe til med koding, alt fra maskinen din. Før du kjører en modell kan du få en rapport på om systemet ditt kan håndtere det. Dette lar deg bruke tid og ressurser kun på kompatible modeller.

Funksjoner

- Filvedlegg og RAG:Du kan laste opp PDF-, docx-, txt- og CSV-filer under chatboksen og få svar deretter.

- Tilpasningsområde:Den tilbyr flere fargetemaer og lar deg velge kompleksitetsnivået til grensesnittet.

- Ressurstett:Den tilbyr gratis dokumentasjon og måter å lære og bruke verktøyet på.

Fordeler

- Du kan bruke den på Linux, Mac eller Windows.

- Lokal serveroppsett for utviklere.

- Den tilbyr en kuratert spilleliste med modeller

Ulemper

- Det kan være komplisert å begynne å jobbe, spesielt for nykommere.

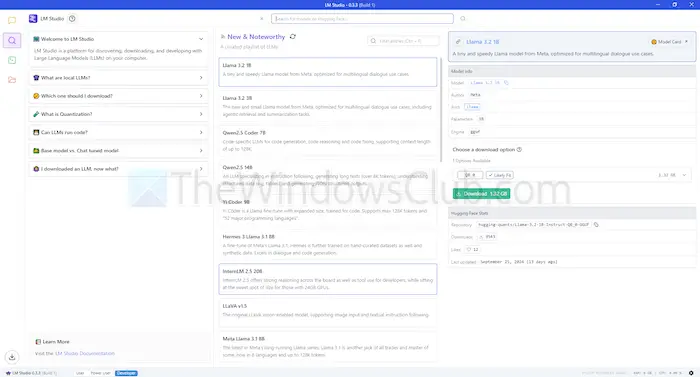

3] GPT4ALL

GPT4ALL er et annet LLM-verktøy som kan kjøre modeller på enhetene dine uten internettforbindelse eller til og med API-integrasjon. Dette programmet kjører uten GPUer, selv om det kan utnytte dem hvis det er tilgjengelig, noe som gjør det egnet for mange brukere. Den støtter også en rekke LLM-arkitekturer, noe som gjør den kompatibel med åpen kildekode-modeller og rammeverk.

Den bruker også llama.cpp som backend for LLM-er, noe som forbedrer modellytelsen på CPUer og GPUer uten avansert infrastruktur. GPT4ALL er kompatibel med både Intel- og AMD-prosessorer; den bruker GPUer for raskere behandling.

Funksjoner

- Lokal filinteraksjon:Modeller kan spørre og samhandle med lokale filer. Som PDF-er eller tekstdokumenter, ved å bruke lokale dokumenter.

- Effektiv:Mange modeller er tilgjengelige i 4-bitsversjoner, som bruker mindre minne og prosessering.

- Omfattende modellbibliotek:GPT4ALL har over 1000 åpen kildekode-modeller fra depoter som Hugging Face.

Fordeler

- Åpen kildekode og transparent

- Den tilbyr en spesifikk pakke for bedrifter å bruke AI lokalt.

- GPT4ALL fokuserer sterkt på personvern

Ulemper

- Begrenset støtte for ARM-prosessorer som Chromebook

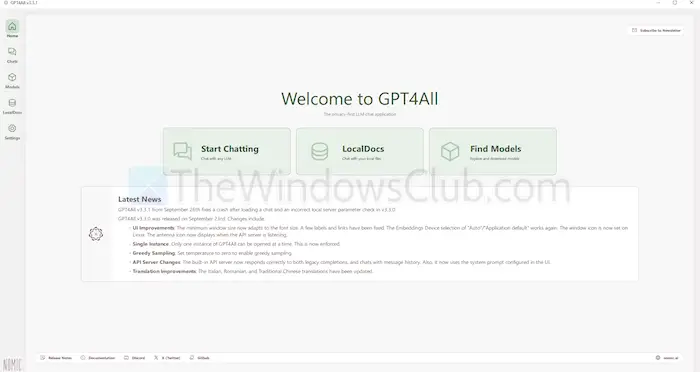

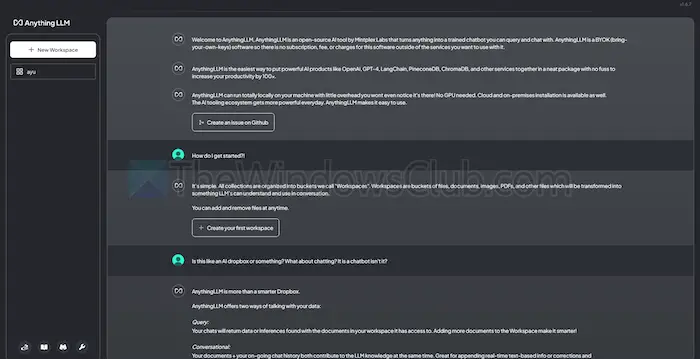

4] Alt LLM

AnythingLLM er en åpen kildekode LLM som tilbyr høy tilpasning og en privat AI-opplevelse. Den lar brukere distribuere og kjøre LLM-er offline på sine lokale enheter, for eksempel Mac, Windows eller Linux, og sikrer fullstendig

Dessuten vil verktøyet best passe enkeltbrukere som ønsker en enkel å installere løsning med minimalt oppsett. Du kan behandle det som et privat CharGPT-lignende system som bedrifter eller enkeltpersoner kan kjøre.

Funksjoner

- Utviklervennlig:Den har et komplett API for tilpasset integrasjon.

- Verktøyintegrasjon:Du kan integrere flere verktøy og generere API-nøkler.

- Enkelt oppsett:Den har en enkeltklikks installasjonsprosess.

Fordeler

- Fleksibilitet i LLM-bruk

- Dokumentsentrisk

- Plattformen har AI-agenter for å automatisere oppgaver

Ulemper

- Mangler flerbrukerstøtte

- Kompleksitet i avanserte funksjoner

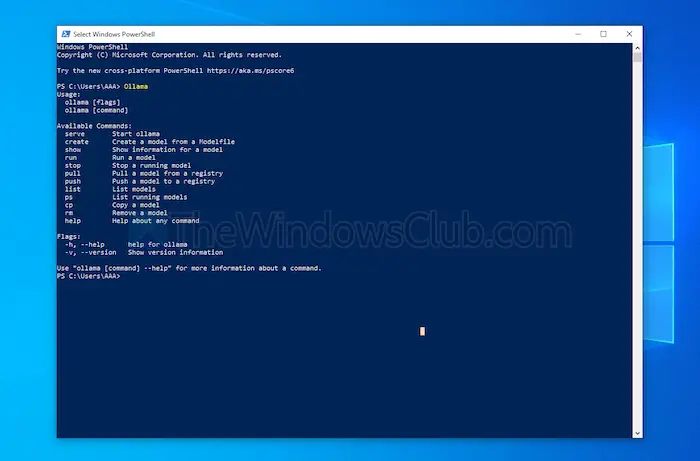

5] Å være

Ollama gir full kontroll over å lage lokale chatbots uten API. For øyeblikket har den de viktigste bidragsyterne som gir hyppige oppdateringer og forbedrer den generelle funksjonaliteten til GitHub. Dette oppdaterer dette verktøyet og gir bedre ytelse enn andre. I motsetning til de andre verktøyene som er diskutert ovenfor, åpner den et terminalgrensesnitt for å installere og starte en modell.

Hver modell du installerer har sine egne konfigurasjoner og vekter, slik at du unngår konflikter med annen programvare på maskinen din. Sammen med kommandolinjegrensesnittet har Ollama en API som er kompatibel med OpenAI. Du kan enkelt integrere dette verktøyet med et som bruker OpenAI-modeller.

Funksjoner

- Lokal distribusjon:Ollama lar deg kjøre store språkmodeller offline, for eksempel Llama, Mistral eller andre.

- Modelltilpasning:Avanserte brukere kan angi atferd i modeller ved hjelp av en modusfil.

- OpenAI API-kompatibilitet:Den har en REST API som er kompatibel med OpenAIs API.

- Ressursstyring:Den optimerer CPU- og GPU-bruken, og overbelaster ikke systemet.

Fordeler

- Du kan få en samling av modeller.

- Den kan importere modeller fra åpen kildekode-biblioteker som PyTorch.

- Ollama kan integreres med enorm bibliotekstøtte

Ulemper

- Det gir ikke et grafisk brukergrensesnitt

- Krever store krav til lagring

Konklusjon

Oppsummert tilbyr lokale LLM-verktøy et verdig alternativ til skybaserte modeller. De tilbyr personvern og kontroll på neste nivå uten kostnad. Enten du sikter etter brukervennlighet eller tilpasning, tilbyr verktøyene som er oppført en rekke behov og ekspertisenivåer.

Avhengig av dine behov, for eksempel prosessorkraft og kompatibilitet, kan noen av disse utnytte AIs potensiale uten å gå på akkord med personvernet eller kreve abonnementsavgifter.

![Kan ikke opprette filer, kan ikke oppgradere Windows [Fix]](https://elsefix.com/tech/tejana/wp-content/uploads/2025/01/Windows-11-Assistant-error.jpg)