Vuoi che i tuoi dati rimangano privati e non lascino mai il tuo dispositivo? I servizi Cloud LLM spesso prevedono tariffe di abbonamento continue basate sulle chiamate API. Anche gli utenti in aree remote o con connessioni Internet inaffidabili non preferiscono specificatamente i servizi cloud. Allora qual è la soluzione?

Fortunatamente, gli strumenti LLM locali possono eliminare questi costi e consentire agli utenti di eseguire modelli sul proprio hardware. Gli strumenti elaborano i dati anche offline in modo che nessun server esterno possa accedere alle tue informazioni. Avrai anche un maggiore controllo sull'interfaccia specifica del tuo flusso di lavoro.

In questa guida abbiamo raccolto iStrumenti LLM locali gratuitiper soddisfare tutte le tue condizioni soddisfacendo al tempo stesso le tue esigenze di privacy, costi e prestazioni.

Ecco alcuni strumenti LLM locali gratuiti che sono stati selezionati con cura e testati personalmente.

- Gen

- Studio LM

- GPT4ALL

- Qualsiasi cosa LLM

- Essere

1] gennaio

Conosci ChatGPT? Se è così, Jan è una versione che funziona offline. Puoi eseguirlo sul tuo dispositivo personale senza Internet. Ti consente di generare, analizzare ed elaborare privatamente dati di testo sulla tua rete locale.

Viene fornito con modelli di prim'ordine come Mistral, Nvidia o OpenAI che puoi utilizzare senza inviare dati a un altro server. Questo strumento è adatto se dai la prioritàe desideri una solida alternativa ai LLM basati su cloud.

Caratteristiche

- Modelli precostruiti:Fornisce modelli AI installati pronti per l'uso senza procedure aggiuntive.

- Personalizzazione:Cambia il colore della dashboard e rendi il tema solido o traslucido.

- Controllo ortografico:Utilizza questa opzione per correggere gli errori di ortografia.

Pro

- Importa i tuoi modelli utilizzando la sorgente Hugging Face.

- Supporta estensioni per la personalizzazione.

- Gratuito

Contro

- Meno supporto da parte della comunità Jan non dispone del supporto da parte della comunità e gli utenti potrebbero trovare meno tutorial e risorse.

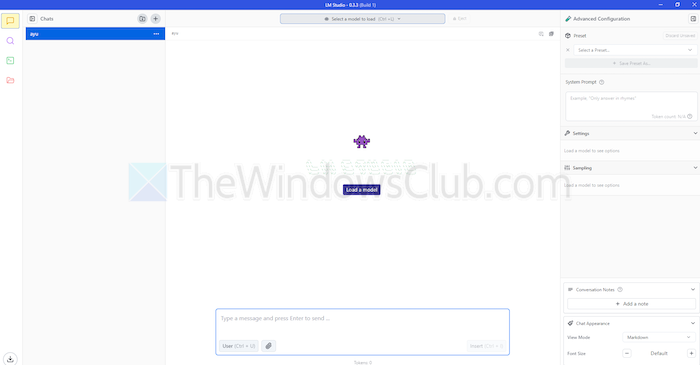

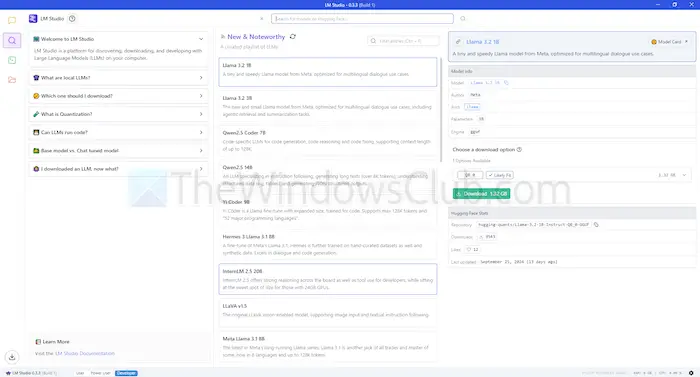

2] Studio LM

LM Studio è un altro strumento per utilizzare modelli linguistici, come ChatGPT localmente. Offre modelli ampi e potenziati per comprendere e rispondere alle tue richieste. Ma, a differenza dei modelli basati su cloud, rimani sul tuo dispositivo. In altre parole, c’è più privacy e controllo sul suo utilizzo.

LM Studio può riassumere testi, generare contenuti, rispondere alle domande desiderate o persino assistere nella codifica, tutto dal tuo computer. Prima di eseguire un modello, puoi ottenere un rapporto sulla capacità del tuo sistema di gestirlo. Ciò ti consente di dedicare tempo e risorse solo a modelli compatibili.

Caratteristiche

- File allegati e RAG:Puoi caricare file PDF, docx, txt e CSV nella chat e ottenere risposte di conseguenza.

- Gamma di personalizzazione:Offre più temi di colore e ti consente di scegliere il livello di complessità dell'interfaccia.

- Denso di risorse:Offre documentazione gratuita e modi per apprendere e utilizzare lo strumento.

Pro

- Puoi usarlo su Linux, Mac o Windows.

- Configurazione del server locale per gli sviluppatori.

- Offre una playlist curata di modelli

Contro

- Potrebbe essere complesso iniziare a lavorare, soprattutto per i nuovi arrivati.

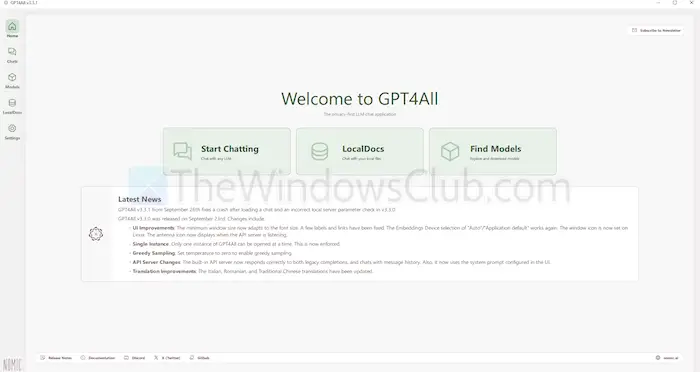

3]GPT4ALL

GPT4ALL è un altro strumento LLM in grado di eseguire modelli sui tuoi dispositivi senza una connessione Internet o anche l'integrazione API. Questo programma funziona senza GPU, anche se può sfruttarle se disponibili, il che lo rende adatto a molti utenti. Supporta inoltre una gamma di architetture LLM, che lo rendono compatibile con modelli e framework open source.

Utilizza inoltre llama.cpp come backend per LLM, che migliora le prestazioni del modello su CPU e GPU senza infrastruttura di fascia alta. GPT4ALL è compatibile sia con processori Intel che AMD; utilizza GPU per un'elaborazione più rapida.

Caratteristiche

- Interazione file locale:I modelli possono eseguire query e interagire con i file locali. Come PDF o documenti di testo, utilizzando Documenti locali.

- Efficiente:Molti modelli sono disponibili nelle versioni a 4 bit, che utilizzano meno memoria ed elaborazione.

- Ampia libreria di modelli:GPT4ALL ha oltre 1000 modelli open source da repository come Hugging Face.

Pro

- Open source e trasparente

- Offre un pacchetto specifico per le aziende per utilizzare l'intelligenza artificiale a livello locale.

- GPT4ALL si concentra fortemente sulla privacy

Contro

- Supporto limitato per processori ARM come i Chromebook

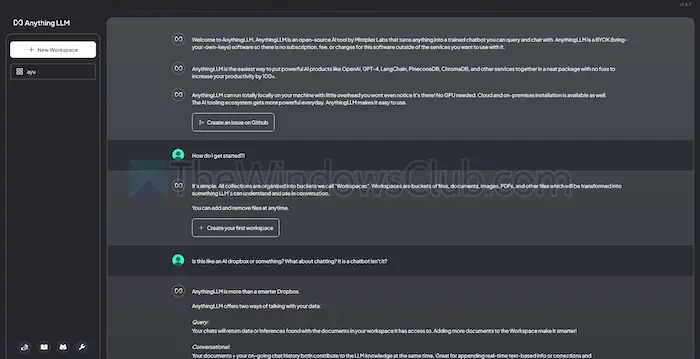

4] TuttoLLM

AnythingLLM è un LLM open source che offre un'elevata personalizzazione e un'esperienza IA privata. Consente agli utenti di distribuire ed eseguire LLM offline sui propri dispositivi locali, come Mac, Windows o Linux, garantendone il completamento

Inoltre, lo strumento si adatterà meglio ai singoli utenti che desiderano una soluzione facile da installare con una configurazione minima. Puoi trattarlo come un sistema privato simile a CharGPT che le aziende o gli individui possono gestire.

Caratteristiche

- Facile per gli sviluppatori:Ha un'API completa per l'integrazione personalizzata.

- Integrazione degli strumenti:Puoi integrare strumenti aggiuntivi e generare chiavi API.

- Configurazione semplice:Ha un processo di installazione con un solo clic.

Pro

- Flessibilità nell'utilizzo di LLM

- Documento incentrato

- La piattaforma dispone di agenti AI per automatizzare le attività

Contro

- Manca il supporto multiutente

- Complessità nelle funzionalità avanzate

5] Essere

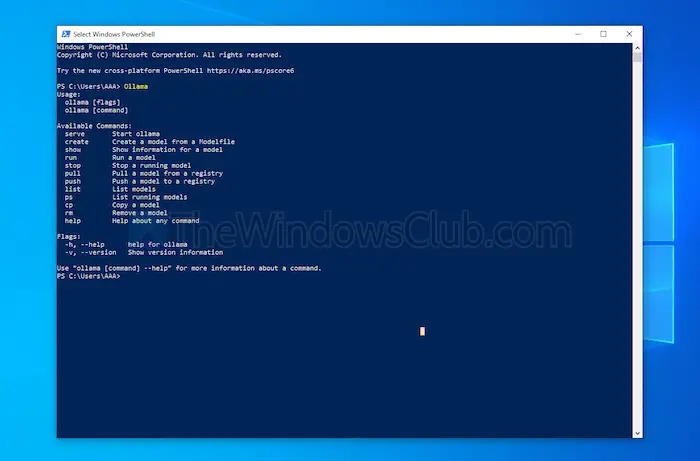

Ollama offre il pieno controllo della creazione di chatbot locali senza API. Attualmente conta i contributori più significativi che forniscono aggiornamenti frequenti e migliorano la funzionalità complessiva di GitHub. Questo aggiorna questo strumento e fornisce prestazioni migliori rispetto ad altri. A differenza degli altri strumenti discussi sopra, apre un'interfaccia terminale per installare e avviare un modello.

Ogni modello installato ha le proprie configurazioni e pesi, evitando conflitti con altri software sulla tua macchina. Insieme alla sua interfaccia a riga di comando, Ollama ha un'API compatibile con OpenAI. Puoi facilmente integrare questo strumento con uno che utilizza i modelli OpenAI.

Caratteristiche

- Distribuzione locale:Ollama ti consente di eseguire modelli linguistici di grandi dimensioni offline, come Llama, Mistral o altri.

- Personalizzazione del modello:Gli utenti avanzati possono impostare il comportamento nei modelli utilizzando un Modefile.

- Compatibilità API OpenAI:Ha un'API REST compatibile con l'API di OpenAI.

- Gestione delle risorse:Ottimizza l'utilizzo di CPU e GPU, senza sovraccaricare il sistema.

Pro

- È possibile ottenere una raccolta di modelli.

- Può importare modelli da librerie open source come PyTorch.

- Ollama può integrarsi con un eccezionale supporto della libreria

Contro

- Non fornisce un'interfaccia utente grafica

- Richiede grandi requisiti di spazio di archiviazione

Conclusione

In sintesi, gli strumenti LLM locali offrono una valida alternativa ai modelli basati su cloud. Offrono privacy e controllo di livello superiore senza alcun costo. Sia che tu miri alla facilità d'uso o alla personalizzazione, gli strumenti elencati offrono una varietà di esigenze e livelli di competenza.

A seconda delle tue esigenze, come potenza di elaborazione e compatibilità, ognuno di questi può sfruttare il potenziale dell'intelligenza artificiale senza compromettere la privacy o richiedere costi di abbonamento.

![Il caricatore del portatile emette un ronzio [risolvere]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/12/Laptop-charger-making-buzzing-noise.png)

![Trova Excel non funziona [fissare]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/12/Excel-Find-is-not-working.jpg)

![Volume ReFS inaccessibile dopo l'aggiornamento [fissare]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/10/ReFS-volume-inaccessible-after-update.jpg)