データをプライバシーを保ち、デバイスから決して外に出さないことを望みますか?クラウド LLM サービスには、多くの場合、API 呼び出しに基づいた継続的なサブスクリプション料金が発生します。遠隔地にいるユーザーやインターネット接続が不安定なユーザーであっても、特にクラウド サービスを好みません。それで、解決策は何でしょうか?

幸いなことに、ローカル LLM ツールを使用すると、これらのコストが削減され、ユーザーはハードウェア上でモデルを実行できるようになります。このツールはデータをオフラインで処理するため、外部サーバーがユーザーの情報にアクセスすることはできません。また、ワークフローに固有のインターフェイスをより詳細に制御できるようになります。

このガイドでは、無料のローカル LLM ツールプライバシー、コスト、パフォーマンスのニーズを満たしながら、すべての条件を満たします。

Windows 11 PC 上で LLM をローカルで実行するための無料ツール

ここでは、厳選され個人的にテストされた無料のローカル LLM ツールをいくつか紹介します。

- 1月

- LMスタジオ

- GPT4ALL

- 何でもLLM

- であること

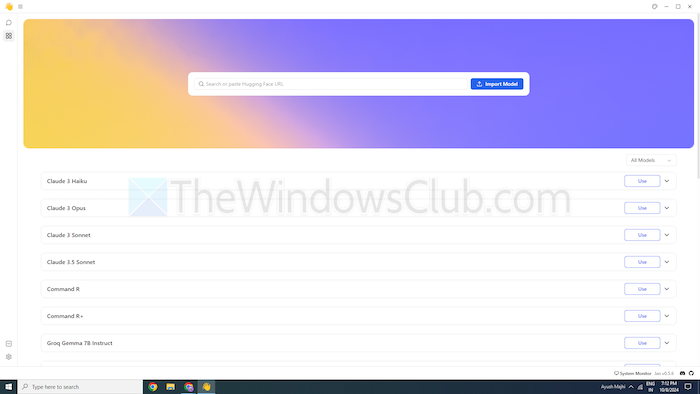

1] 1月

ChatGPT をご存知ですか?その場合、Jan はオフラインで動作するバージョンです。インターネットがなくても、個人のデバイスで実行できます。これにより、ローカル ネットワーク上でテキスト データをプライベートに生成、分析、処理できます。

Mistral、Nvidia、OpenAI などの一流モデルが付属しており、データを別のサーバーに送信せずに使用できます。このツールは、次のことを優先する場合に適しています。そして、クラウドベースの LLM に代わる堅牢な代替手段を求めています。

特徴

- 事前に構築されたモデル:追加の手順なしですぐに使用できる、インストール済みの AI モデルが提供されます。

- カスタマイズ:ダッシュボードの色を変更し、テーマを単色または半透明にします。

- スペルチェック:スペルミスを修正するには、このオプションを使用します。

長所

- Hugging Face ソースを使用してモデルをインポートします。

- カスタマイズのための拡張機能をサポートしています。

- 無料

短所

- コミュニティ サポートが少ない Jan にはコミュニティ サポートが不足しており、ユーザーが見つけられるチュートリアルやリソースが少なくなる可能性があります。

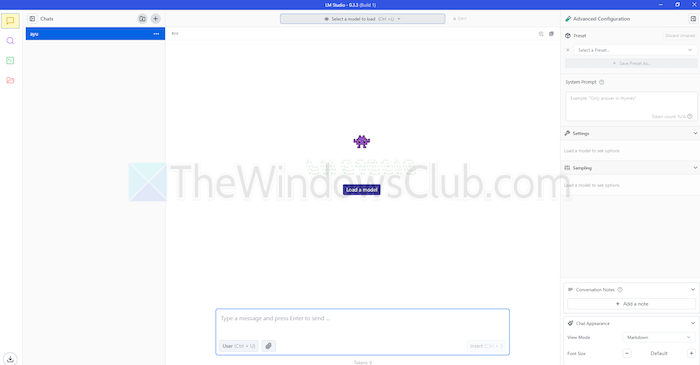

2]LMスタジオ

LM Studio は、ChatGPT などの言語モデルをローカルで使用するためのもう 1 つのツールです。お客様のリクエストを理解し、それに応えるための大規模で強化されたモデルを提供します。ただし、クラウドベースのモデルとは異なり、デバイス上に留まります。言い換えれば、プライバシーとその使用に対する制御が強化されます。

LM Studio は、テキストの要約、コンテンツの生成、必要な質問への回答、さらにはコーディングの支援まで、すべてお使いのマシンから行うことができます。モデルを実行する前に、システムがモデルを処理できるかどうかに関するレポートを取得できます。これにより、互換性のあるモデルにのみ時間とリソースを費やすことができます。

特徴

- 添付ファイルと RAG:PDF、docx、txt、CSV ファイルをチャットボックスにアップロードすると、それに応じて応答を受け取ることができます。

- カスタマイズの範囲:複数のカラーテーマが提供され、インターフェイスの複雑さのレベルを選択できます。

- リソース密度:無料のドキュメントと、ツールを学習して使用する方法を提供します。

長所

- Linux、Mac、または Windows で使用できます。

- 開発者向けのローカル サーバーのセットアップ。

- 厳選されたモデルのプレイリストを提供します

短所

- 特に新人にとって、仕事を始めるのは複雑かもしれません。

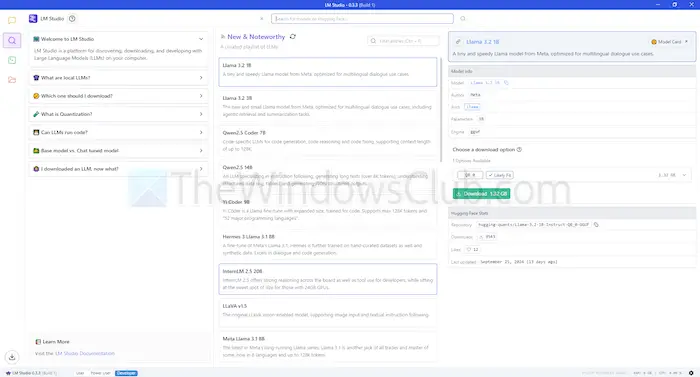

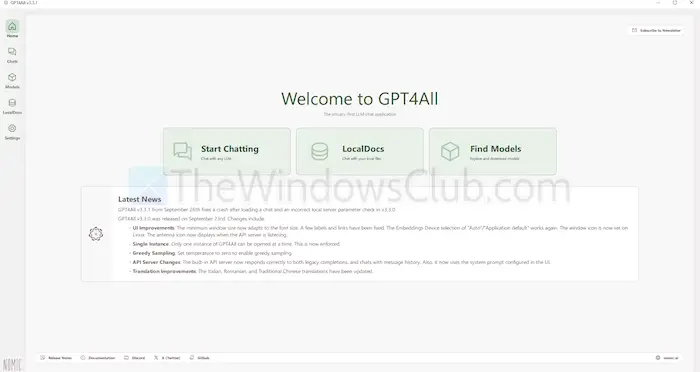

3]GPT4ALL

GPT4ALL は、インターネット接続や API 統合がなくてもデバイス上でモデルを実行できるもう 1 つの LLM ツールです。このプログラムは GPU なしで実行されますが、利用可能な場合はGPU を活用できるため、多くのユーザーに適しています。また、さまざまな LLM アーキテクチャもサポートしているため、オープンソースのモデルやフレームワークとの互換性が得られます。

また、llama.cpp を LLM のバックエンドとして使用し、ハイエンドのインフラストラクチャを使用せずに CPU および GPU でのモデルのパフォーマンスを向上させます。 GPT4ALL は、Intel プロセッサと AMD プロセッサの両方と互換性があります。 GPU を使用して処理を高速化します。

特徴

- ローカルファイルの相互作用:モデルはローカル ファイルに対してクエリを実行したり、ローカル ファイルと対話したりできます。 PDF やテキスト ドキュメントと同様に、ローカル ドキュメントを使用します。

- 効率的:多くのモデルは、メモリと処理の使用量が少ない 4 ビット バージョンで利用できます。

- 広範なモデル ライブラリ:GPT4ALL には、Hugging Face などのリポジトリからの 1,000 を超えるオープンソース モデルが含まれています。

長所

- オープンソースと透明性

- 企業が AI をローカルで使用するための特定のパッケージを提供します。

- GPT4ALL はプライバシーに重点を置いています

短所

- Chromebook などの ARM プロセッサの限定的なサポート

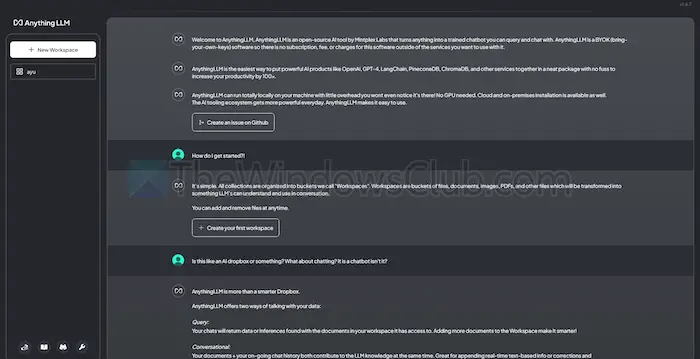

4]何でもLLM

AnythingLLM は、高度なカスタマイズとプライベート AI エクスペリエンスを提供するオープンソース LLM です。これにより、ユーザーは Mac、Windows、Linux などのローカル デバイス上で LLM をオフラインで展開して実行できるため、完全な作業が保証されます。

さらに、このツールは、最小限のセットアップで簡単にインストールできるソリューションを求める単一ユーザーに最適です。これを、企業または個人が実行できるプライベート CharGPT のようなシステムとして扱うことができます。

特徴

- 開発者に優しい:カスタム統合のための完全な API が備わっています。

- ツールの統合:追加のツールを統合し、API キーを生成できます。

- 簡単なセットアップ:シングルクリックのインストールプロセスがあります。

長所

- LLM の使用における柔軟性

- ドキュメント中心

- プラットフォームにはタスクを自動化する AI エージェントが搭載されています

短所

- マルチユーザーサポートがない

- 高度な機能の複雑さ

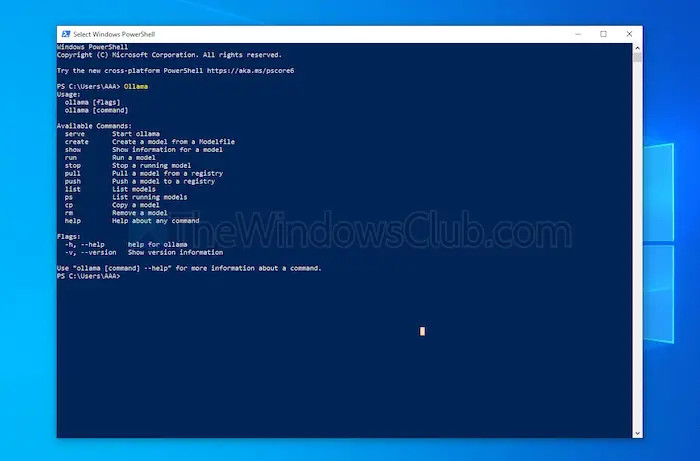

5] なる

Ollama では、API を使用せずにローカル チャットボットの作成を完全に制御できます。現在、頻繁に更新を提供し、GitHub の全体的な機能を向上させる最も重要な貢献者がいます。これによりこのツールが更新され、他のツールよりも優れたパフォーマンスが提供されます。上で説明した他のツールとは異なり、モデルをインストールして起動するためのターミナル インターフェイスが開きます。

インストールする各モデルには独自の構成と重みがあり、マシン上の他のソフトウェアとの競合を回避します。 Ollama には、コマンド ライン インターフェイスに加えて、OpenAI と互換性のある API があります。このツールは、OpenAI モデルを使用するツールと簡単に統合できます。

特徴

- ローカル展開:Ollama を使用すると、Llama、Mistral などの大規模な言語モデルをオフラインで実行できます。

- モデルのカスタマイズ:上級ユーザーは、Modefile を使用してモデルの動作を設定できます。

- OpenAI API の互換性:OpenAI の API と互換性のある REST API を備えています。

- リソース管理:システムに過負荷をかけずに、CPU と GPU の使用率を最適化します。

長所

- モデルのコレクションを入手できます。

- PyTorch などのオープンソース ライブラリからモデルをインポートできます。

- Ollama は強力なライブラリ サポートと統合できます

短所

- グラフィック ユーザー インターフェイスは提供されません

- 大規模なストレージ要件が必要

結論

要約すると、ローカル LLM ツールは、クラウドベースのモデルに代わる価値のある代替手段を提供します。次のレベルのプライバシーと制御を無料で提供します。使いやすさを目的とするかカスタマイズするかを目的とするかどうかにかかわらず、リストされているツールはさまざまなニーズと専門知識レベルを提供します。

処理能力や互換性などのニーズに応じて、プライバシーを侵害したり、サブスクリプション料金を必要としたりすることなく、AI の可能性を活用できます。

![副操縦士は「サインアウトされたようです」と言います [修正]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/11/It-looks-youve-been-signed-out.png)

![VirtualBox がプロダクト キーを読み取れない [修正]](https://elsefix.com/tech/tejana/wp-content/uploads/2024/11/VirtualBox-cannot-read-the-product-key.png)